Launch-Analyse nVidia GeForce GTX 1070

Hauptlinks

- Startseite

- News

- 7-Tage-News

- Linklisten der News

- Newsindex-Übersicht

- AMD RDNA3

- AMD RDNA4

- AMD RDNA5

- Intel Xe

- Intel Battlemage

- Intel Celestial

- nVidia Ada Lovelace

- nVidia Blackwell

- nVidia Rubin

- AMD Zen 4

- AMD Zen 5

- AMD Zen 6

- Intel Raptor Lake

- Intel Meteor Lake

- Intel Lunar Lake

- Intel Arrow Lake

- Intel Panther Lake

- Intel Nova Lake

- Artikel

- Downloads

Suchen

Launch-Analyse nVidia GeForce GTX 1070

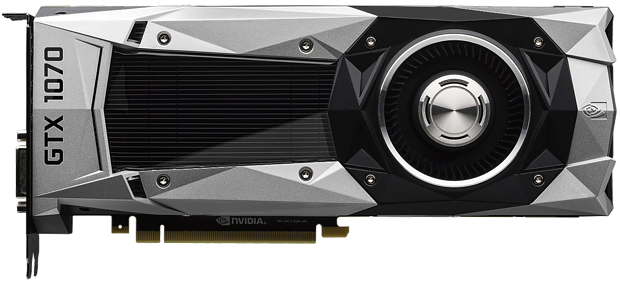

Mit der GeForce GTX 1070 stellt nVidia in der Nacht vom 29. auf 30. Mai (Launchdatum in den USA ist damit der 29. Mai, in Mitteleuropa dagegen schon der 30. Mai) seine zweite Grafikkarte auf Basis des GP104-Chips aus der Pascal-Architektur vor. Mit der GeForce GTX 1070 will man nach der Hochpreis-Karte GeForce GTX 1080 ein klar niedrigeres Preissegment besetzen, auch wenn es mit 379 Dollar Listenpreis für die (nachfolgenden) Herstellerdesigns und damit zu erwartende Straßenpreise im Bereich von 430 bis 500 Euro erneut nicht wirklich kostengünstig wird. Unsere Launch-Analyse wird nachfolgend beleuchten, was die einzelnen Launchtests bezüglich Hardware-Daten, realen Taktraten, Overclocking-Eignung, Stromaufnahme, Lautstärke und natürlich zur Performance dieser neuen nVidia-Karte zu sagen haben, sowie nachfolgend (auf Basis möglichst vieler Testresultate) eine generelle Performance-Einordnung der GeForce GTX 1070 vornehmen.

Feature-technisch ist die GeForce GTX 1070 gleich zur GeForce GTX 1080, insofern sei für Fragen zum GP104-Chip auf die Launch-Analyse zur GeForce GTX 1080 verwiesen. Einzig allein wird von der GeForce GTX 1070 kein GDDR5X-Speicher verwendet, nVidia begnügt sich hierbei mit gewöhnlichem GDDR5-Speicher, welcher allerdings auf 4000 MHz ungewöhnlich hoch taktet. Alle weiteren Unterschiede liegen allein in Abspeckungen bezüglich deaktivierter Hardware-Einheiten des GP104-Chips: Von 4 Raster-Engines, 2560 Shader-Einheiten und 160 Textureneinheiten (TMUs) wurde exakt ein Viertel deaktiviert – es bleiben also bei der GeForce GTX 1070 noch 3 Raster-Engines, 1920 Shader-Einheiten und 120 Textureneinheiten übrig, sprich aktiv.

Bis auf die andere Speichersorte gibt es keine Abspeckungen am Speicher-Subsystem – sowohl die Interface-Breite, die Anzahl der Raster Operation Units (ROPs) als auch die Größe des Level2-Caches bleiben gegenüber der GeForce GTX 1080 identisch. nVidia vermeidet hiermit die schlechte Presse, welche man seinerzeit bei der GeForce GTX 970 kassiert hatte – und über den Wechsel von GDDR5X auf GDDR5 kommt auch so eine deutlich niedrigere Speicherbandbreite heraus (20% weniger gegenüber der GeForce GTX 1080).

| Radeon R9 Fury X | GeForce GTX 980 Ti | GeForce GTX 1070 | GeForce GTX 1080 | |

|---|---|---|---|---|

| Chipbasis | AMD Fiji, 8,9 Mrd. Transist. in 28nm auf 596mm² Chipfläche | nVidia GM200, 8 Mrd. Transist. in 28nm auf 601mm² Chipfläche | nVidia GP104, 7,2 Mrd. Transist. in 16nm auf 314mm² Chipfläche | |

| Architektur | GCN 1.2, DirectX 12 Feature-Level 12_0 | Maxwell 2, DirectX 12 Feature-Level 12_1 | Pascal, DirectX 12 Feature-Level 12_1 | |

| Features | Mantle, Vulkan, Asynchonous Compute, VSR, CrossFire, FreeSync, TrueAudio | Vulkan, DSR, SLI, G-Sync, PhysX | Vulkan, Asynchonous Compute, DSR, SLI, G-Sync, PhysX | |

| Technik | 4 Raster-Engines, 4096 Shader-Einheiten, 256 TMUs, 64 ROPs, 4096 Bit DDR HBM1-Interface, 2 MB Level2-Cache | 6 Raster-Engines, 2816 Shader-Einheiten, 176 TMUs, 96 ROPs, 384 Bit GDDR5-Interface, 3 MB Level2-Cache | 3 Raster-Engines, 1920 Shader-Einheiten, 120 TMUs, 64 ROPs, 256 Bit GDDR5-Interface, 2 MB Level2-Cache | 4 Raster-Engines, 2560 Shader-Einheiten, 160 TMUs, 64 ROPs, 256 Bit GDDR5X-Interface, 2 MB Level2-Cache |

| Taktraten | ≤1050/500 MHz (Ø-Chiptakt: 1050 MHz) |

1000/1075/3500 MHz (Ø-Chiptakt: 1114 MHz) |

1506/1683/4000 MHz (Ø-Chiptakt: ? MHz) |

1607/1733/2500 MHz (Ø-Chiptakt: 1694 MHz) |

| Speicherausbau | 4 GB HBM1 | 6 GB GDDR5 | 8 GB GDDR5 | 8 GB GDDR5X |

| Layout | DualSlot, AiO-Wakü | DualSlot | DualSlot | DualSlot |

| Kartenlänge | 19,7cm | 27,0cm | 27,0cm | 27,0cm |

| Ref./Herst./OC | ✓/✗/✗ | ✓/✓/✓ | ✓/✓/✓ | ✓/✓/✓ |

| Stromstecker | 2x 8pol. | 1x 6pol. + 1x 8pol. | 1x 8pol. | 1x 8pol. |

| TDP | 275W (TBP) | 250W (GCP) | 150W (GCP) | 180W (GCP) |

| Idle-Verbrauch | 21W | 13W | ~7W | 7W |

| Spiele-Verbrauch | 289W | 236W | ~145W | 171W |

| Ausgänge | HDMI 1.4a (kein HDCP 2.2), 3x DisplayPort 1.2 | DualLink DVI-I, HDMI 2.0 (kein HDCP 2.2), 3x DisplayPort 1.2 | DualLink DVI-D, HDMI 2.0b, 3x DisplayPort 1.2 (DP1.4-ready) | DualLink DVI-D, HDMI 2.0b, 3x DisplayPort 1.2 (DP1.4-ready) |

| FullHD Perf.Index | 670% | 750% | 800% | 960% |

| 4K Perf.Index | 100% | 100% | 107% | 132% |

| Listenpreis | 649$ | 649$ | 379$/449$ | 599$/699$ |

| Straßenpreis | 610-680€ | 580-630€ | zu erwarten für 430-500€ (Verkaufsstart 10. Juni) |

670-790€ |

| Release | 24. Juni 2015 | 31. Mai 2015 | 30. Mai 2016 | 17. Mai 2016 |

Dies passt auch grob zur Abspeckung bei der Rechenleistung, welche ungefähr bei 25% weniger gegenüber der GeForce GTX 1080 liegt. Genauer läßt sich dies noch nicht sagen, da sich derzeit kein Test ernsthaft mit der real anliegenden Chiptaktrate beschäftigt hat. Sicherlich gibt es hier und da Taktraten-Angaben, jene beziehen sich allerdings auf einzelne Benchmark-Titel und sind daher klar nichtssagend, weisen potentiell gesehen sogar in eine falsche Richtung. Leider scheinen die Launchtests unter hartem Zeitdruck entstanden zu sein, da wichtige Nebenpunkte oftmals nur kurz oder gar nicht abgehandelt wurden. Zudem fällt auf, das Launchtests von einigen wichtigen Hardware-Magazinen gänzlich fehlen – und damit auch wichtige Nebeninformationen.

Ohne ernsthafte Aussagen zum real anliegenden Chiptakt ist natürlich auch kein echter Rohleistungs-Vergleich möglich – aber man sicherlich grob angeben, das die GeForce GTX 1070 bei der Rechenleistung auf Höhe der GeForce GTX 980 Ti und Titan X rangiert, bei der Speicherbandbreite jedoch klar (-24%) hinter diesen zurückliegt. An dieser Stelle muß dann nVidias verbesserte Farbkompression beim GP104-Chip zum Einsatz kommen – was aber auch schon bei der GeForce GTX 1080 bestens funktioniert hat, welche bei der Speicherbandbreite minimal gegenüber GeForce GTX 980 Ti und Titan X zurückliegt, dennoch aber 25-30% Mehrperformance oben drauf legen konnte.

| GeForce GTX 980 Ti | GeForce GTX Titan X | GeForce GTX 1070 | GeForce GTX 1080 | |

|---|---|---|---|---|

| nominelle Taktraten | 1000/1075/3500 MHz | 1000/1075/3500 MHz | 1506/1683/4000 MHz | 1607/1733/2500 MHz |

| Power-Limit | 250W (+10% möglich) | 250W (+10% möglich) | 150W (+12% möglich) | 180W (+20% möglich) |

| Temperatur-Limit | 83°C (+10% möglich) | 83°C (+10% möglich) | 83°C (+10% möglich) | 83°C (+10% möglich) |

| maximaler Boost-Takt | 1240 MHz 1215 MHz |

1202 MHz 1190 MHz |

1911 MHz | 1886 MHz |

| durchschn. realer Takt | 1114 MHz | 1067 MHz | ? | 1667 MHz 1722 MHz |

| reale Rechenleistung (SE * realer Takt) |

6,27 TFlops | 6,55 TFlops | ? (ca. 6½ TFlops) |

8,67 TFlops |

Besonders auffällig ist das Fehlen wichtiger Nebentests bei den Messungen zur Stromaufnahme der reinen Grafikkarte – wo wir lange Zeit keinen Launch mehr hatten, wo sich nur ein einziges Meßergebnis in dieser Frage ergab. Wie grundsätzlich falsch dabei Messungen des Gesamtsystems sein können, zeigt sich bestmöglich beim Guru3D, wo man ausgehend von Messungen des Gesamtsystems eine Kalkulation bezüglich der Stromaufnahme der reinen Grafikkarte aufgetan hat. Jene "Kalkulation" liegt mit 161 Watt für die GeForce GTX 1070 nicht besonders weit vom realen Ergebnis entfernt – und ist dennoch grundsätzlich falsch, da die Karte mit ihrem festen Power-Limit von 150 Watt nirgendwo mehr als diese 150 Watt aufnehmen kann. Auf Basis des einzelnen realen Meßwerts seitens der PC Games Hardware sowie den Erfahrungen bei der GeForce GTX 1080 schätzen wir daher den Stromverbrauch der GeForce GTX 1070 auf ~145 Watt ein.

| HW.fr | Heise | HT4U | PCGH | TPU | Tom's | TweakPC | Ø | Perf./TDP | |

|---|---|---|---|---|---|---|---|---|---|

| GeForce GTX 1080 | 8W 154W |

6W 178W |

9,5W 173,7W |

7W 166W |

7W 173W |

7W 171W |

960% 180W |

||

| GeForce GTX 1070 | 8,5W 147,7W |

~7W ~145W |

800% 150W |

||||||

| GeForce GTX Titan X | 15W 228W |

11,8W 250,0W |

18W 242W |

11W 223W |

9W 224W |

13W 240W |

780% 250W |

||

| GeForce GTX 980 Ti | 15W 226W |

13W 244W |

12,8W 250,0W |

15W 236W |

11W 211W |

10,4W 233,5W |

10,9W 213W |

13W 236W |

750% 250W |

| GeForce GTX 980 | 12W 155W |

? 173W |

11,2W 180,0W |

11,5W 160W |

8W 156W |

15W 185W |

12W 174W |

600% 165W |

|

| GeForce GTX 970 | 18W 151W |

11,2W 160,0W |

15W 164W |

9W 161W |

20W 168W |

12W 161W |

520% 145W |

||

| Radeon R9 390X | 18W 329W |

14,4W 301,5W |

13W 344W |

14,4W 293,6W |

14,9W 233W |

15W 303W |

570% 275W |

||

| Radeon R9 Nano | 14W 185W |

11W 186W |

14,6W 168,8W |

13W 183W |

600% 175W |

||||

| Radeon R9 Fury | 15W 266W |

14,9W 247,2W |

15W 320W |

10W 200W |

16W 254W |

15W 256W |

620% 275W |

||

| Radeon R9 Fury X | 22,5W 293,5W |

20W 273W |

20,0W 311,0W |

21W 329W |

20W 246W |

22,0W 220,7W |

21W 289W |

670% 275W |

Leider ebenfalls nicht viele Stimmmeldungen in deutscher Sprache gab es zur Geräuschentwicklung der GeForce GTX 1070. Allerdings ist diesbezüglich wohl sowieso alles im grünen Bereich, nachdem nVidia im Referenzdesign dieselbe Kühlkonstruktion wie bei der GeForce GTX 1080 verwendet – und jene bei der GeForce GTX 1070 einen Grafikchip mit geringerer Stromaufnahme gegenüber der GeForce GTX 1080 kühlen muß. Ebenso ist klar, das diese Referenz-Kühllösung sich keine Spitzennoten bei der Geräuschvermeidung verdienen kann – dafür ist jene auch nicht gedacht, in dieser Frage sind die (nachfolgenden) Herstellerdesigns üblicherweise nochmals besser aufgestellt.

| Idle-Betrieb | Spiele-Betrieb | Spulenfiepen |

|---|---|---|

| Test von GameStar | ||

| Im Leerlauf kühlt das System die GPU auf 32 Grad und ist mit 38,6 Dezibel bei geschlossenem Gehäuse nicht zu hören. | Unter Last steigt die Temperatur auf heiße 82 Grad und die GTX 1070 rauscht mit 42,3 dBA zwar nicht störend laut, aber dennoch hörbar. | Das bei der GTX 970 oft bemängelte Spulenfiepen ist in unserem Test nicht aufgetreten. |

| Test von PC Games Hardware | ||

| - | Die maximale Lautheit der GTX 1070 Founders Edition in unserem Spieleparcours beträgt vergleichsweise geringe 2,9 Sone. Die automatische Lüftersteuerung setzt in diesem Fall 53 Prozent PWM-Impuls, was circa 2.120 U/min entspricht. In vielen anderen Fällen beträgt die Drehzahl rund 2.000 bis 2.040 (50-51 % PWM), resultierend in einer Lautheit von 2,5 -2,6 Sone. Das ist zwar hörbar, das gleichmäßige Rauschen des Nvidia-Lüfters kommt ohne pfeifende Nebengeräusche aus und ist daher subjektiv erträglich. Gegen das (unter Last) leise Betriebsgeräusch der flüssiggekühlten Radeon R9 Fury X kommt das GTX-1070-Kühldesign jedoch nicht an. Interessant ist, dass die GTX 1080 wesentlich lauter wird (max. 4,2 anstelle von 2,9 Sone), hier wirkt sich die um 20 Prozent höhere Leistungsaufnahme – 180 anstelle von 150 Watt – direkt aus. | Spulenfiepen weist unser Testmuster der GTX 1070 wie auch dasjenige der GTX 1080 der erst ab hohen drei- oder gar vierstelligen Bildraten auf, sofern eine passende 3D-Last anliegt, in ersten Tests im Compute-Bereich (z. B. unter Open CL) haben wir kein Spulenfiepen vernommen. Das Störgeräusch lässt sich auf fast allen leistungsfähigen Grafikkarten provozieren und im Falle der GTX 1070/1080 liegt dessen Niveau auf dem anderer Referenzkarten von AMD und Nvidia. |