- Startseite

- News

- 7-Tage-News

- Linklisten der News

- Newsindex-Übersicht

- AMD RDNA3

- AMD RDNA4

- AMD RDNA5

- Intel Xe

- Intel Battlemage

- Intel Celestial

- nVidia Ada Lovelace

- nVidia Blackwell

- nVidia Rubin

- AMD Zen 4

- AMD Zen 5

- AMD Zen 6

- Intel Raptor Lake

- Intel Meteor Lake

- Intel Lunar Lake

- Intel Arrow Lake

- Intel Panther Lake

- Intel Nova Lake

- Artikel

- Downloads

Hauptlinks

Suchen

13News des 12./13. Oktober 2024

News des 12./13. Oktober 2024

Gerade aufgrund der derzeit weit verbreiteten Meldung, laut Intel würde "Arrow Lake" bei der Spiele-Performance nur ca. 5% hinter Ryzen 7000X3D liegen, muß dringend noch einmal auf die abweichende Benchmark-Methodik der Hersteller bei der Spiele-Performance von PC-Prozessoren hingewiesen werden, welche in dieser Frage (zumeist) um einige Jahre gegenüber dem Stand von guten unabhängigen Testern zurückliegen. Die Hersteller benchen gerade bei CPU-Tests vergleichsweise konventionell: Standard-Benchmarks, die oftmals eigentlich für GPU-Vergleiche dienen, einfach nur verbunden mit der FullHD-Auflösung auf dem "High" Bildqualitäts-Setting. Hier fehlen dann so einige Dinge, welche gute Hardwaretester inzwischen besser machen, um auch wirklich eine CPU-Limitierung hervorzulocken: Dafür passende Benchmark-Sequenzen, Auflösung oftmals kleiner als FullHD, aber wenn FullHD dann wenigstens 1% low Frameraten und auch das genaue Auswählen der Bildqualitäts-Settings nach deren Effekt auf GPU- und CPU-Performance.

| CPU Spiele-Tests | Benchmark-Methodik | Resultat |

|---|---|---|

| übliche Hersteller-Benchmarks | FullHD auf "High"-Settings (aber ohne einzelner Abwägung, welche Settings eher auf GPU oder CPU gehen), average fps, Nutzung zumeist von den gleichen Testsequenzen wie für GPU-Tests | stark reduzierte Unterschiede zwischen den CPUs, im Extremfalls können Core i3 und Core i9 die gleiche Performance aufweisen, weil zumeist einfach nur im GPU-Limit getestet wird |

| unabhängige Hardwaretester | entweder FullHD mit 1% low fps oder aber kleinere Auflösungen als FullHD mit average oder 1% low fps, gute Tester setzen zudem nur jene Bildqualitäts-Settings auf "High/Max", welche einen CPU-Effekt haben, gute Tester suchen sich zudem extra Testsequenzen mit vergleichsweise hoher abgefragter CPU-Leistung | vergleichsweise hohe Unterschiede zwischen den CPUs, da weitgehend im CPU-Limit getestet wird |

Dabei darf alles, was an der CPU zieht, durchaus maximiert sein, der Rest kann hingegen durchaus auf "Low" oder "Medium" gehen. In der Summe der vielen kleinen Maßnahmen ergeben sich somit teils gewaltige Differenzen in der Betrachtung der CPU-Performance derselben Prozessoren. Mit der üblichen Hersteller-Meßmethode kann man locker und leicht mal einen Core i3 genauso schnell wie einen Core i9 "messen" – einfach weil man mit diesem Ansatz sehr oft im GPU-Limit herauskommt, somit nicht wirklich den Prozessor testet. Derselbe Test mit den besten Test-Methoden der unabhängigen Hardwaretester wird dann gänzlich anders ausgehen und vernünftige Performance-Unterschiede zwischen beiden Prozessoren zeigen. Dieser erhebliche Unterschied in der Meßmethodik zwischen den meisten Hersteller-Benchmarks und (guten) unabhängigen Resultaten wäre immer einzukalkulieren, wenn man Spiele-Benchmarks von Herstellern liest.

Aus diesem Blickwinkel heraus sind auch die viel zitierten und sich aus einer Intel-Folie ergebenden 5% Performance-Differenz zwischen "Arrow Lake" und Zen4 X3D eine gewagte Aussage – weil Intels konkrete Testmethodik sehr augenscheinlich nicht dafür ausgelegt ist, echte Performance-Unterschiede zwischen diesen Prozessoren zu produzieren. Wenn Intel zwischen Ryzen 9 9950X und Core i9-14900K nur grob +1% "ausmißt" und es real eher +10% sind, kann es letztlich auch so sein, das es zwischen Core Ultra 9 285K und Ryzen 7 7800X3D keine +5% sind – sondern real eher +15%. Intels Angabe zur Spiele-Performance von Arrow Lake gegenüber Ryzen 7000X3D steht somit auf arg wackeligen Beinen und ist aller Voraussicht nach mit deutlich zu geringerer Performance-Differenz angesetzt, die Realität dürfte deutlich schlechter für Arrow Lake aussehen. Die Angabe "5% Differenz" dürfte vermutlich noch zwei Wochen lang vielfach verbreitet herumgeistern, ehe die Launch-Reviews zu Arrow Lake am 24. Oktober hierzu Klarheit liefern werden.

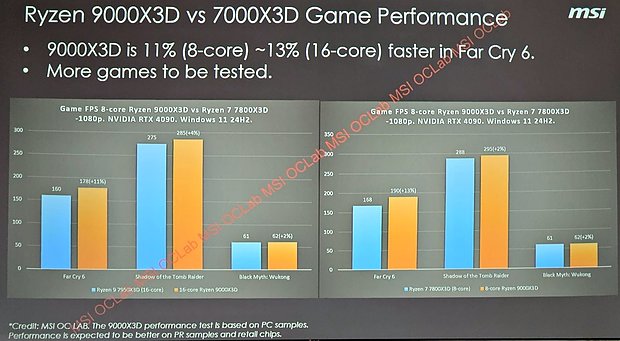

Grundsätzlich in dieselbe Kategorie gehören auch die kürzlichen dargelegten Ryzen 9000X3D Benchmarks seitens MSI, welche in den (knappen) Spiele-Benchmarks auch einige sehr niedrige Performance-Gewinne für Ryzen 9000X3D gesehen haben. Allerdings waren hierbei auch nur drei Test-Spiele im Einsatz, wovon zwei eher suboptimal für Prozessoren-Tests geeignet sind: Shadow of the Tomb Raider hat ein 300-fps-Limit, was alle Zugewinne schon in der Nähe dieser Marke deutlich eindämpft. Und Black Myth: Wukong ist wie bekannt heftig GPU-limitiert selbst unter FullHD. Generell könnten diese MSI-Benchmarks auch durchaus die anderen Schwächen von Hersteller-eigenen Spiele-Benchmarks tragen, wenngleich dies aufgrund fehlender Anmerkungen zu den Testbedingungen bzw. wenig Erfahrungswerten speziell zu MSI derzeit nur eine wohlfeile Vermutung darstellt. Aber es liegt halt durchaus im Rahmen des möglichen, dass hier 2 von 3 Benchmarks keine echten Unterschiede zeigen können und man bei besserer Ausrichtung auf das Herausarbeiten von Differenzen in der CPU-Performance sich eher dem unter Far Cry 6 gezeigtem Ergebnis annähern könnte.

Jenes fällt mit +13% beim Ryzen 7 9800X3D sowie +11% beim Ryzen 9 9950X3D (jeweils gegenüber ihren direkten Vorgängern von Ryzen 7000X3D) durchaus ansprechend aus – wobei natürlich nicht versprochen werden kann, dass dies dann dem Schnitt der unabhängigen Testresultate nahekommen wird. Ganz generell sollte man sich von Ryzen 9000X3D sowieso nicht all zu viel versprechen, nachdem die regulären Ryzen 9000 Prozessoren die faktisch schwächste Ryzen-Generation ergeben haben. Die Grundlage der kommenden neuen X3D-Modelle ist damit einfach nicht gegeben, dass jene plötzlich Bäume ausreißen könnten. Etwas mehr als der Zuwachs an Spiele-Performance der regulären Ryzen 9000 Modelle (im Schnitt nur +4%, dies allerdings erzielt vor allen Patches & Verbesserungen seitens AMD und Microsoft) sollte es durchaus werden, immerhin weist Ryzen 9000X3D nunmehr nachweislich einen geringeren Taktraten-Abstand aus, was auch die Spiele-Performance positiv beeinflussen wird. Es wäre allerdings erstaunlich, wenn es im Schnitt vieler Messungen mehr als 10% Zugewinn bei der Spiele-Performance zwischen Ryzen 7000X3D und 9000X3D geben würde.

Eine kleine Korrektur noch: Die Tabelle der RTX50-Modelle in der Meldung über die GeForce RTX 5070 enthielt für die GeForce RTX 5090 die falsche Anzahl an freigeschalteten Shader-Clustern: Es sind natürlich nur 170, nicht 190 – mit Bitte um Entschuldigung für diesen Lapsus. Im Text war es bereits korrekt notiert, in der Tabelle jedoch falsch eingetragen. An der grundsätzlichen Situation, dass die GeForce RTX 5090 die nominell doppelte Hardware gegenüber der GeForce RTX 5080 bieten wird, ändert sich damit natürlich nichts – dafür würden dann sogar schon 168 Shader-Cluster ausreichen, da die GeForce RTX 5080 "nur" über 84 davon verfügen wird. Diese überdimensionale Differenz deutet zudem zielsicher auf das Nachfolgen einer "GeForce RTX 5080 Ti" mit einer größeren Abspeckung des GB202-Chips hin – entweder im Rahmen einer regelrechten Refresh-Generation oder einfach später zur (für nVidia) passenden Zeit dazwischengestreut.

| Chip | Hardware | VRAM | TDP | max. Boardpower | Vorstellung | |

|---|---|---|---|---|---|---|

| GeForce RTX 5090 | GB202 | 170 SM @ 512-bit | 32 GB GDDR7 | ? | 600W | angebl. CES 2025 |

| GeForce RTX 5080 | GB203 | 84 SM @ 256-bit | 16 GB GDDR7 | ? | 400W | angebl. CES 2025 |

| GeForce RTX 5070 | GB205 | ≤50 SM @ 192-bit | 12 GB GDDR7 | ? | 250W | angebl. CES 2025 |

| Hinweis: Angaben zu noch nicht offiziell vorgestellter Hardware basieren auf Gerüchten & Annahmen | ||||||

Gut als Nachtrag zum kürzlich angeschnittenen Thema benutzbar, wo eine KI versagt, ist ein Bericht der Telepolis über die Mühen einer Journalismus-KI, einen Spielbericht zu einem abgebrochenen Fußball-Spiel zusammenzufassen. An dieser Stelle konnte die KI nicht mit dem für sie ungewöhnlichen Problem umgehen, dass das eine Team zwar mehr Tore erzielt hatte als das andere, es aber dennoch wegen des Spiel-Abbruchs nominell keinen Sieger gab. Interessant hier auch die Fehlleistung einiger Beobachter dieser KI-Fehlleistung, welche davon ausgingen, dass die KI demzufolge falsch programmiert wäre. Doch heutige KIs werden nicht derart spezifisch programmiert, die eigentlichen KI-Erkenntnisse erfolgen allein aus den Trainingsdaten. Und in denen liegt die Crux: Erstens werden alle darin enthaltenen (menschlichen) Fehler, Bevorzugungen und Stereotypen vom "Nachplapperautomat" KI genauso übernommen.

Und zweitens kann die KI nur aus Massen an Ergebnissen etwas lernen, bei zu wenigen Daten zu Sonderfällen ergeben sich noch keine klaren Muster – und damit keine sinnvolle Auslegung der KI, wie in diesem konkreten Fall passiert. Letzte Woche war es die Wirkung der Corona-Pandemie auf der Wirtschaftssystem, was die KIs (als virtuelle Unternehmenslenker) außer Tritt brachte. Das Grundprinzip hierbei ist jeweils gleich: Sonderfälle sind unglaublich schwer zu trainieren. Der einfache Weg, die KI mit Massen an Fallbeispielen zuzuschütten und jene ohne menschliches Zutun einfach daran herumrechnen lassen bzw. jene selbst die Muster erkennen zu lassen, funktioniert bei Sonderfällen einfach nicht. Und dies ganz einfach, weil jene zu selten sind und daher nicht genügend Trainingsdaten im Rahmen einer KI vorhanden sind (für einen Menschen kann dagegen ein einzelnes gutes Beispiel ausreichen). Und dies führt wiederum zur einfachen Erkenntnis: KI kann Prinzip-bedingt nur für 95-99% der auftretenden Fälle ein akkurates Ergebnis liefern, die konkrete Zahl hängt vom Themengebiet ab.

Die restlichen 1-5% sind für KI so lange nicht erreichbar, wie KI eigentlich nur erkennt, welche Sätze und Sprachfetzen Menschen zum jeweiligen Thema gebildet haben, sprich so lange KI eine reine Häufigkeitsrechnung menschlicher Wortmeldungen bleibt. Jene 1-5% würde man nur mit dem Verständnis der hinter allen Entscheidungen stehenden Gründe und Logiken erreichen können – wovon KI heutzutage noch weit entfernt ist. Und so lange dies so bleibt, muß eine seriöse KI derart eingerichtet werden, gar nicht erst zu versuchen, die restlichen 1-5% zu lösen. So lange es sich nur um Textausgabe handelt, ist dies alles nicht das ganz große Problem. Aber es wird zweifellos zu einem Problem, wenn KI Handlungen in der realen Welt auslösen darf und dann keine Schranke für Sonderfälle besitzt. Nur als Beispiel: Eine heutige KI könnte wie im Film "Wargames" niemals ganz allein zur Entscheidung kommen, dass das dort gespielte Kriegsspiel nicht zu gewinnen ist – dafür wäre echte Intelligenz notwendig, was kein Merkmal heutiger KIs darstellt.