- Startseite

- News

- 7-Tage-News

- Linklisten der News

- Newsindex-Übersicht

- AMD RDNA3

- AMD RDNA4

- AMD RDNA5

- Intel Xe

- Intel Battlemage

- Intel Celestial

- nVidia Ada Lovelace

- nVidia Blackwell

- nVidia Rubin

- AMD Zen 4

- AMD Zen 5

- AMD Zen 6

- Intel Raptor Lake

- Intel Meteor Lake

- Intel Lunar Lake

- Intel Arrow Lake

- Intel Panther Lake

- Intel Nova Lake

- Artikel

- Downloads

Hauptlinks

Suchen

Grafikkarten

Grafikkarten-Marktüberblick Juli 2008

Sonntag, 27. Juli 2008

/ von

Leonidas

Einige Zeit nach dem Launch der neuen Performance- und HighEnd-Modelle von ATI und nVidia ist es nun wirklich Zeit für einen neuen Marktüberblick der derzeit verfügbaren Grafikkarten, ist der alte Marktüberblick vom April inzwischen an der Leistungsspitze maßgeblich überholt. Mit dem neuen Marktüberblick sind nun alle verfügbaren Modelle wieder in der Übersicht, sind die Preise an das aktuelle Niveau angepasst und sind vor allem die heftigen Preissenkungen von nVidia bei der GeForce GTX 200 Serie bereits mit eingearbeitet.

Was bringt uns der GT200?

Mittwoch, 18. Juni 2008

/ von

aths

Die Eckdaten des neuen Grafikchips sind bekannt: 240 skalare Shader bei knapp 1300 MHz, 80 Textureinheiten, die jeweils pro Takt ein bilineares Samples berechnen können, bei gut 600 MHz und 1024 Mebibyte GDDR3-Speicher, die via 512-Interface angebunden sind. Außerdem bleibt es bei Direct3D 10.0. Wie das alles einzuschätzen ist, wollen wir uns heute ansehen.

Rechenkraft

Die Leistungsfähigkeit alter Grafikkartengenerationen

Dienstag, 26. August 2008

/ von

BlackArchon &

warmachine79

Jeder, der sich gerne mit PCs und hier insbesondere mit Spielen und Hardware auseinandersetzt, weiß es; es ist ein teures Hobby. Dank des rasanten technologischen Fortschritts auf diesem Markt ist heute bereits veraltet, was gestern noch State-of-the-Art war. Die logische Konsequenz ist das Aufrüsten der Hardware, für Spieler ist da natürlich die Grafikkarte der erste Ansatzpunkt.

Die Notwendigkeit einer Aufrüstung wird aber, im allgemeinen Rummel der Fachpresse um den Release neuer Hardware, nicht immer ausreichend hinterfragt. Dessen wird sich das 3DCenter in diesem Test annehmen. Wir wollen nach Abschluss des Tests folgende Fragen beantwortet wissen:

- Welche Grafikkartengeneration präsentiert sich im verhältnismäßig besten Licht?

Das Sommer-Portfolio von ATI und nVidia

Montag, 5. Mai 2008

/ von

Leonidas

Obwohl das derzeitige Grafikkarten-Angebot gerade im oberen Mainstream- bis HighEnd-Bereich eigentlich schon recht rund ausschaut und zugleich mit RV770 und GT200 schon zum Sommer die Vorboten neuer Grafikkarten-Generation zu erwarten sind, werden ATI und nVidia in der nächsten Zeit ihr Grafikkarten-Angebot weiter verfeinern, was zum einen weitere neue Grafikkarten bedeutet und zum anderen auch das Lebensende von bisher im Markt stehenden Produkten.

Grafikkarten-Marktüberblick April 2008

Dienstag, 15. April 2008

/ von

Leonidas

Nach dem Launch der GeForce 9800 GTX ist es nun endlich wieder Zeit für einen neuen Marktüberblick der derzeit verfügbaren Grafikkarten. Schließlich ist der Marktüberblick vom Januar inzwischen etwas unaktuell geworden, haben ATI und nVidia einige neue Grafiklösungen auf den Markt geworfen und sind andere ältere Lösungen nunmehr nicht mehr im Angebot bzw. uninteressant geworden. Daneben gab es natürlich auch etliche Bewegungen bei den Preisen, maßgeblich begünstigt durch den andauernd günstigen Dollar-Kurs ging es dabei fast überall klar herunter mit den Euro-Preisen.

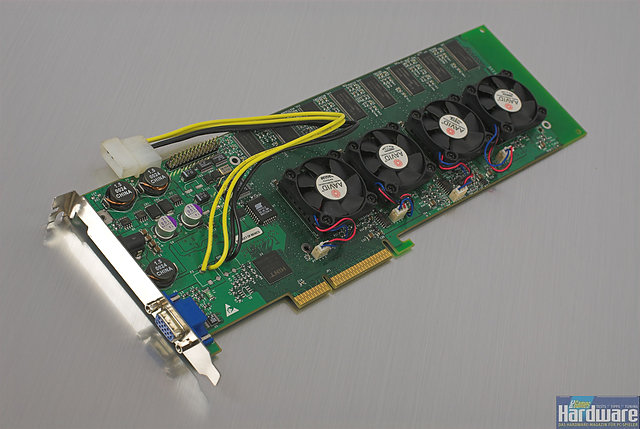

3dfx Voodoo5 6000 Review

Sonntag, 21. Januar 2007

Vor mehr als sechs Jahren, am 15. Dezember 2000, endete eine Ära: Der Pionier gefilterter Polygonbeschleunigung am PC schloss seine Pforten. Hauptkonkurrent nVidia übernahm 3dfx mitsamt aller Patente und Technologien für 112 Millionen Dollar. Aus, Schluss, vorbei – ein schwarzer Tag für die bis dahin große Community. Doch eines blieb zu klären: Hätte der Abschied auch mit einem Knall vonstatten gehen können?

Dieser Artikel widmet sich der Beantwortung eben dieser Frage. Gegenstand der Betrachtung ist die schnellste Grafikkarte der Voodoo5-Serie, ein Relikt längst vergangener Tage. Die Rede ist natürlich von der Voodoo5 6000 AGP, dem nie offiziell erschienenen Meisterstück der 3dfx-Entwicklung.

Die Geschichte

Wir erinnern uns: Anfang 1999 auf der Comdex erstmals der Öffentlichkeit präsentiert, schlägt diese Grafikkarte ein wie eine Bombe. Sage und schreibe vier Grafikprozessoren finden auf der Platine Platz. Was man damals nicht wusste: Sie wird es niemals in den Retail-Markt schaffen.

Das damals gezeigte Modell ist eine Präsentation des "Urdesigns", welches noch auf die 2x2-Chipanordnung setzt – und nicht annähernd funktionsfähig. Im Laufe der Entwicklung stieß man auf gravierende Probleme beim Platinenlayout und verwarf es schließlich, um auf das mittlerweile weltbekannte Aussehen mit vier aneinander gereihten Chips umzusatteln. Auch hier kämpfte man bis zum Schluss mit Problemen, allen voran den Instabilitäten bei hoher Last. Dieser Bug, der sich hartnäckig in allen existierenden Voodoo5 6000 Prototypen hält, steckt im PCI-Subsystem. Er war es auch, der das Erscheinen der Voodoo5 6000 maßgeblich verhinderte.

Vergebliche Aktionen wie das Heruntertakten neuerer Revisionen von den ursprünglich vorgesehenen 183 auf 166 MHz brachten folglich auch keine Abhilfe. Und dann kam er, der Schlussstrich, resultierend aus den gigantischen Entwicklungskosten und wiederholt enttäuschenden Quartalsergebnissen. Am 13. November 2000 gibt 3dfx bekannt, alle SLI-Patente an die Tochterfirma Quantum3D (noch existent) abzutreten und sich aus dem Grafikkartengeschäft zurückzuziehen. Alle bisher gebauten Voodoo5 6000 Prototypen laufen damit auch zu Quantum3D über – naja, fast ...

Man sagt, dass etwa 200 dieser Prototypen verschiedener Revisionen existieren. Davon sind aber bei weitem nicht alle funktionsfähig – diesbezüglich schwirrt die Zahl 100 durch das Internet, weltweit wohlgemerkt! Wer dann davon einen Teil außerhalb der Quantum3D-Firmenmauern brachte, kann wohl niemand genau sagen, wie auch die Zahl zwischenzeitlich verstorbener V56k-Karten unbekannt ist. Die meisten Prototypen befinden sich mittlerweile in den Händen treuer Fans, doch hin und wieder stehen auch heutzutage ein paar Exemplare zum Verkauf im Internet.

Allen gemein ist der für eine sechs Jahre alte Grafikkarte extrem hohe Preis: Mindestens 500 Euro muss man für ein defektes Exemplar hinlegen, eine funktionierende Voodoo5 6000 mit standardisierten 183 MHz kann aber auch schnell das Doppelte bis Dreifache kosten. Gemessen an ihrer "Population" und den Preisen aktueller HighEnd-Grafikkarten schrumpft die Zahl aber förmlich, denn im Gegensatz zu den neuesten Kreationen von ATI und nVidia ist die Voodoo5 6000 seit Jahren erstaunlich wertstabil – sehr zum Leidwesen weniger gut betuchter Interessenten.

Hier kommen nun die Autoren dieser Zeilen ins Spiel: Fast sechs Jahre hat es gedauert, doch heute können wir stolz das präsentieren, was allen Interessenten damals so schmerzlich vorenthalten wurde: Ein Review der Voodoo5 6000. Wir sind uns bewusst, dass wir damit nicht die ersten sind, denn ein paar Tests fanden im Laufe der Zeit den Weg ins Internet (und letztes Jahr auch ins Printmagazin PC Games Hardware). Doch wir behaupten, garantiert alle Fragen zu 3dfx' letzter funktionierender Schöpfung zu beantworten. Genau die Fragen, welche wir uns beim Lesen vergangener Tests stellten – und mehr.

Die Testexemplare

Für diesen Artikel kamen gleich zwei Voodoo5 6000 Karten zum Einsatz. Beide gehören den bekanntesten und stabilsten jemals gebauten Revisionen an: Der "Final Revision 3700-A", erkennbar an diesen Zahlen hergestellt in der 37. Kalenderwoche des Jahres 2000. Bei Prototypen dieser Art kann man schon fast von voll funktionsfähigen Grafikkarten sprechen. "Fast" nur deswegen, weil auch sie von Haus aus den oben beschriebenen PCI-Bug aufweisen. Der Clou ist, dass dieses Problem doch noch seine Lösung fand – bedauerlicherweise aber erst nachdem 3dfx Unmengen an Ressourcen daran verbrauchte und letztendlich scheiterte.

Hank Semenec, der mittlerweile bei Quantum3D tätige "Godfather" der Voodoo5 6000, erschuf in seiner Freizeit das so genannte "PCI-Rework", welches die Instabilitäten beseitigt. Es gibt zwei Arten dieses Bugfixes, ein internes und ein externes, welche jeweils eine unserer Testkarten aufweist. Beide sind damit ausgestattet voll einsatzfähig und die revolutionären AA-Modi, denen im folgenden eine große Rolle zukommt, arbeiten damit absolut stabil. Hank Semenec ist es durch eine Reparatur weiterhin zu verdanken, dass eine unserer beiden Voodoo5 6000 Karten überhaupt funktioniert. Großen Dank abermals dafür!

Die Voodoo5 6000 AGP Rev. 3700-A: Runde 31 Zentimeter misst sie. Man beachte einerseits die auf dem Kopf stehende HiNT-Bridge links von den GPUs sowie die direkt auf das PCB gelötete Stromversorgung. Das ursprünglich vorgesehene "Voodoo Volts" Netzteil ist bei heutigen Netzteilen nicht zwingend nötig (und zudem sehr rar), hätte damals aber so manchen Rechner erst Voodoo5-6000-fähig gemacht (Bild: © PC Games Hardware).

Die Rückseite offenbart Unmengen an SMDs (Surface Mounted Devices) in für damalige Verhältnisse sehr hoher Dichte (Bild: © PC Games Hardware).

Das externe PCI-Rework unserer Benchkarte. Daneben schön zu sehen: Der "Not for resale" Aufkleber, der die Karte eindeutig als Prototypen ausweist (Bild: © PC Games Hardware).

Bevor wir allerdings mit Frameraten um uns werfen, wollen wir erst noch einen Blick auf die zugrundeliegende Technik, die damit erzeugte Bildqualität und natürlich die Testsettings werfen.

Überblick über die Direct3D10-Generation von ATI und nVidia

Freitag, 16. März 2007

/ von

Leonidas

Mit den News-Meldungen der letzten Tage verdichtet sich immer mehr das Bild über die im April/Mai zu erwartenden Direct3D10-Grafikkarten von ATI und nVidia. Mittels dieser Produktoffensive in nur recht wenigen Wochen wird dann von beiden Grafikchip-Entwicklern ein komplettes Programm an Direct3D10-Grafikkarten für alle drei Marktsegmente zur Verfügung stehen. Dieser Artikel soll als aktueller Überblick über das bisher bekannte Wissen zu diesen neuen Karten dienen und wird zu diesem Zweck auch beim Auftauchen neuer Informationen entsprechend ergänzt werden.

Damit wollen wir uns ohne weitere große Vorrede in die Präsentation der entsprechend bekannten Daten zu den HighEnd-Grafikkarten stürzen. nVidia hat ja schon den Anfang in Form der Veröffentlichung des G80-Chips gemacht, während ATIs R600-Chip mehrfache Verspätungen hinnehmen musste. Auch macht es die letzte Verspätung möglich, daß ATI nochmals etwas an den R600-Grafikboards herumbastelt, die entsprechenden Daten gerade zum R600-Chip und dessen Grafikboards sind also weiterhin mit Vorsicht zu genießen.

| HighEnd Direct3D10-Grafikkarten | |||

|---|---|---|---|

| Grafikchip | Grafikkarte | Stromverbrauch | Preis & Verfügbarkeit |

| ATI R600 ca. 720 Mill. Tranistoren in 80nm, 320 Shader-Einheiten, 16 TMUs, 512 Bit DDR Speicherinterface |

Radeon HD 2900 XTX wie R600-Chip, Chiptakt angeblich 800 MHz, Speichertakt angeblich 1100 MHz, Speichergröße 1 GB, höchstwahrscheinlich vollständig HDCP-kompatibel, DualSlot-Design |

unklar: frühere ATI-eigene Angaben sprachen von sehr hohen Stromaufnahmen, inzwischen scheint sich da aber etwas in die positive Richtung hin getan zu haben | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai, Verfügbarkeit allerdings erst im Juni (oder gar erst im dritten Quartal), Listenpreis angeblich 499 Dollar |

| Radeon HD 2900 XT wie R600-Chip, Chiptakt 745 MHz, Speichertakt 800 MHz, Speichergröße 512 MB, höchstwahrscheinlich vollständig HDCP-kompatibel, DualSlot-Design |

unklar: frühere ATI-eigene Angaben sprachen von sehr hohen Stromaufnahmen, inzwischen scheint sich da aber etwas in die positive Richtung hin getan zu haben | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai mit sofortiger Verfügbarkeit, Listenpreis angeblich 399 Dollar | |

| Radeon HD 2900 XL die Unterschiede zu den XT/XTX-Versionen sind unklar – höchstwahrscheinlich deutlich niedrigere Taktraten, mit einer geringen Chance sind aber auch deaktivierte Hardware-Einheiten möglich, Speichergröße 512 MB, höchstwahrscheinlich vollständig HDCP-kompatibel, DualSlot-Design |

unklar | komplett unbekannt | |

| nVidia G80 681 Mill. Transistoren in 90nm, 128 Shader-Einheiten (16 Vec8-ALUs), 32 TMUs (acht Quad-TMUs), 24 ROPs, 384 Bit DDR Speicherinterface (6x 64 Bit) |

GeForce 8800 Ultra wie G80-Chip, Chiptakt 612 MHz, Shadertakt 1512 MHz, Speichertakt 1080 MHz, Speichergröße 768 MB, vollständig HDCP-kompatibel, DualSlot-Design |

ca. 140-145 Watt realer Verbrauch | Launch am 2. Mai, Verfügbarkeit ab 15. Mai zu einem europäischen Listenpreis von 699 Euro |

| GeForce 8800 GTX wie G80-Chip, Chiptakt 575 MHz, Shadertakt 1350 MHz, Speichertakt 900 MHz, Speichergröße 768 MB, vollständig HDCP-kompatibel, DualSlot-Design |

132 Watt realer Verbrauch, nVidia empfiehlt ein Netzteil von mindestens 450 Watt Gesamtleistung mit 30A auf der 12V-Leitung | erhältlich für derzeit um die 490 Euro | |

| GeForce 8800 GTS wie G80-Chip, jedoch: nur 96 Shader-Einheiten, nur 24 TMUs, nur 20 ROPs, nur 320 Bit Speicherinterface, Chiptakt 500 MHz, Shadertakt 1200 MHz, Speichertakt 800 MHz, Speichergrößen 320 und 640 MB, vollständig HDCP-kompatibel, DualSlot-Design |

106 Watt realer Verbrauch (640-MB-Version), nVidia empfiehlt ein Netzteil von mindestens 400 Watt Gesamtleistung mit 26A auf der 12V-Leitung | erhältlich für derzeit um die 260 (320 MB) bzw. 350 (640 MB) Euro | |

Deutlich besser ist hingegen die Informationslage bei den kommenden Mainstream-Grafikkarten um die beiden Grafikchips ATI RV630 und nVidia G84. Beide werden wohl plangemäß im April/Mai vorgestellt werden, auch mit der Verfügbarkeit entsprechender Grafikkarten ist für diesen Zeitraum zu rechnen. Bei den RV630-Abkömmlingen sind derzeit die jeweiligen Namenssuffixe noch nicht bekannt, sondern bislang nur die Codenamen der entsprechenden Referenzboards von ATI:

| Mainstream Direct3D10-Grafikkarten | |||

|---|---|---|---|

| Grafikchip | Grafikkarte | Stromverbrauch | Preis & Verfügbarkeit |

| ATI RV630 65nm, 120 Shader-Einheiten, 8 TMUs, 128 Bit DDR Speicherinterface |

Radeon HD 2600 XT wie RV630-Chip, Chiptakt 800 MHz, Speichergrößen 256 und 512 MB, vollständig HDCP-kompatibel, SingleSlot-Design |

unklar: frühere ATI-eigene Angaben sprachen von hohen Stromaufnahmen, neuere Bilder zeigen die Karten allerdings ohne extra Stromanschluß, sprich unterhalb von 75 Watt TDP liegend | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai mit sofortiger Verfügbarkeit, Listenpreis angeblich 199 Dollar |

| Radeon HD 2600 Pro Unterschiede zur XT-Version sind unklar – allerdings vermutlich nur geringere Taktfrequenzen, Speichergröße 256 MB, vollständig HDCP-kompatibel, SingleSlot-Design |

unklar: frühere ATI-eigene Angaben sprachen von hohen Stromaufnahmen, neuere Bilder zeigen die Karten allerdings ohne extra Stromanschluß, sprich unterhalb von 75 Watt TDP liegend | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai mit sofortiger Verfügbarkeit, Listenpreis angeblich 179 Dollar | |

| Radeon HD 2600 Unterschiede zur XT-Version sind unklar – in diesem Fall sind allerdings neben geringeren Taktfrequenzen auch deaktivierte Hardware-Einheiten möglich (das 128 Bit DDR Speicherinterface bleibt allerdings), Speichergrößen 256 und 512 MB, vollständig HDCP-kompatibel, SingleSlot-Design |

unklar: frühere ATI-eigene Angaben sprachen von hohen Stromaufnahmen, neuere Bilder zeigen die Karten allerdings ohne extra Stromanschluß, sprich unterhalb von 75 Watt TDP liegend | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai mit sofortiger Verfügbarkeit, Listenpreis noch unbekannt | |

| nVidia G84 289 Mill. Transistoren in 80nm, 32 Shader-Einheiten (vier Vec8-ALUs), 16 TMUs (zwei Octo-TMUs), 8 ROPs, 128 Bit DDR Speicherinterface |

GeForce 8600 GTS wie G84-Chip, Chiptakt 675 MHz, Shadertakt 1450 MHz, Speichertakt 1000 MHz, Speichergröße 256 MB, vollständig HDCP-kompatibel, SingleSlot-Design |

49 Watt realer Verbrauch (Karten haben extra Power-Anschluß) | erhältlich für derzeit um die 190 Euro |

| GeForce 8600 GT wie G84-Chip, Chiptakt 540 MHz, Shadertakt 1190 MHz, Speichertakt 700 MHz, Speichergröße 256 MB, Varianten mit/ohne vollständiger HDCP-Kompatibilität, SingleSlot-Design |

geschätzt 40 Watt realer Verbrauch (Karten haben keinen extra Power-Anschluß) | erhältlich für derzeit um die 130 Euro | |

Und letztlich werden ATI und nVidia mit den Grafikchips RV610 und G86 auch noch neue LowCost-Modelle für Direct3D10 an den Start bringen. Einschränkenderweise gilt hier dazuzusagen, daß meistens nur die Top-Modelle der jeweiligen LowCost-Grafikkarten empfehlenswert sind, die niedrigeren Modelle sind in ihrer Leistung gewöhnlich zu beschnitten, um als sinnvolle 3D-Beschleuniger durchgehen zu können. Gänzlich herausgelassen haben wir nachfolgend im übrigen die LowProfile-Lösungen von ATI, da diese in aller Regel nur im OEM-Markt vertrieben werden:

| LowCost Direct3D10-Grafikkarten | |||

|---|---|---|---|

| Grafikchip | Grafikkarte | Stromverbrauch | Preis & Verfügbarkeit |

| ATI RV610 65nm, 40 Shader-Einheiten, 4 TMUs, 128 Bit DDR Speicherinterface |

Radeon HD 2400 XT wie RV610-Chip, Chiptakt 700 MHz, Speichertakt 700 MHz, Speichergröße 256 MB, vollständig HDCP-kompatibel, SingleSlot-Design |

um die 35 Watt TDP | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai mit sofortiger Verfügbarkeit, Listenpreis angeblich 99 Dollar |

| Radeon HD 2400 Unterschiede zur XT-Version sind unklar – es wird sich sicherlich um geringere Taktrate aber womöglich auch um auch deaktivierte Hardware-Einheiten handeln, Speichertakt 400 MHz, Speichergröße 256 MB, vollständig HDCP-kompatibel, SingleSlot-Design, passiv gekühlte Designs zu erwarten, keine Hardware-Unterstützung für CrossFire |

unter 25 Watt TDP | Vorstellung für die Presse am 23./24. April (unter NDA), echter Launch angeblich 14. Mai mit sofortiger Verfügbarkeit, Listenpreis noch unbekannt | |

| nVidia G86 210 Mill. Transistoren in 80nm, 16 Shader-Einheiten (zwei Vec8-ALUs), 8 TMUs (eine Octo-TMU), 128 Bit DDR Speicherinterface |

GeForce 8500 GT wie G86-Chip, Chiptakt 450 MHz, Shadertakt 900 MHz, Speichertakt 400 MHz, Speichergröße 256 MB, Varianten mit/ohne vollständiger HDCP-Kompatibilität, SingleSlot-Design |

unbekannt | erhältlich für derzeit um die 80 Euro |

| GeForce 8400 GS Unterschiede zur GeForce 8500 GT sind unklar – es wird sich sicherlich um geringere Taktrate aber womöglich auch um auch deaktivierte Hardware-Einheiten handeln, SingleSlot-Design |

unbekannt | Launch angeblich Ende April, Verfügbarkeit und Preissituation sind noch unbekannt, geht womöglich nur in den OEM-Markt | |

| GeForce 8300 GS Unterschiede zur GeForce 8500 GT sind unklar – in diesem Fall sind neben geringeren Taktfrequenzen aber auch deaktivierte Hardware-Einheiten anzunehmen (mit sicherlich nur 64 Bit Speicherinterface), SingleSlot-Design |

unbekannt | Launch angeblich Ende April, Verfügbarkeit und Preissituation sind noch unbekannt, geht womöglich nur in den OEM-Markt | |

Wie an den großen Lücken bei einzelnen Grafikkarten zu sehen, sind derzeit die Angaben insgesamt noch zu dürftig, um bereits größere Marktprognosen abgeben zu können. Auffallend ist allerdings, daß sowohl ATI wie auch nVidia bei den Mainstream-Grafiklösungen es mit Grafikkarten mit nur 128bittigem Speicherinterface probieren wollen. Man wird dies zwar wohl durch hohe Speichertakte etwas ausgleichen wollen, nichts desto trotz könnte es zu einer Situation kommen, wo die derzeit vertriebenen Karten des Mainstream-Segments aufgrund ihrer 256bittigen Speicherinterfaces eine vergleichbare oder gar bessere Leistung bieten werden können.

Ganz allgemein sind die aktuellen Mainstream- und niedrigeren HighEnd-Lösungen auch weiterhin noch gute Marktchancen einzuräumen, da ATI und nVidia derzeit im Preisbereich von 170 bis 240 Euro wirklich sehr viel Hardware für doch recht moderate Preise verkaufen. Zu nennen wären hier insbesondere Radeon X1950 Pro, Radeon X1950 XT und GeForce 7950 GT, wobei sich zumindestens hinter den beiden letztgenannten Karten einwandfreie HighEnd-Lösungen verbergen, die jetzt einfach nur dermaßen günstig geworden sind, daß sie ins Mainstream-Segment hinabrutschen.

Davon abgesehen gilt es weitere Informationen zu den neuen Direct3D10-Karten abzuwarten, ehe man weitere Einschätzungen dieser vornehmen kann. Wie schon vorstehend angemerkt, wird dieser Artikel mit dem Auftauchen neuer Details entsprechend aktualisiert werden.

nVidia stellt die ersten Mainstream Direct3D10-Grafikkarten vor

Dienstag, 17. April 2007

/ von

Leonidas

Mit dem heutigen Tag kommen nun endlich auch erste Mainstream-Grafikkarten aus der Direct3D10-Generation in den Markt. Wie schon beim HighEnd-Chip G80 ist auch hier wieder nVidia der Vorreiter, wenngleich natürlich auch von ATI demnächst ähnliches zu erwarten ist. Die primäre Aufgabe der neu in den Markt kommenden Karten ist dabei natürlich die Ablösung der "alten" Mainstream-Generation um die Chips G73 (GeForce 7600 Serie) und G71 (GeForce 7900/7950 Serie). Gleichzeitig setzt man damit aber auch den Grundstein für die Durchsetzung von Direct3D10-Grafikkarten im Markt, schließlich sind die bisherigen Verkäufe der HighEnd-Lösungen GeForce 8800 GTS und GTX natürlich bei weitem nicht ausreichend, um von einem beachtbaren Marktanteil an verkauften Direct3D10-Lösungen zu sprechen.

Für den interessierten User dürfte aber in erster Linie interessant sein, daß sich nun Direct3D10-Hardware auch in der Preisspanne von 100 bis 200 Euro erwerben läßt. Hierzu wirft nVidia zwei neue Grafikchips in die Waagschale: Die LowCost-Lösung G86 und die Mainstream-Lösung G84. Über beide wurde in letzter Zeit an dieser Stelle schon viel berichtet und auch wurden schon viele (letztlich passende) Informationen zusammengetragen – beim entscheidenden Punkt der Anzahl der Shader-Einheiten irrte die Vorab-Berichterstattung allerdings: So spendierte nVidia dem G84-Chip nur vier Vec8-ALUs und damit ganze 32 Shader-Einheiten.

Die Funktionsblöcke wurden allerdings dahingehend verändert, das die beim G80-Chip noch doppelt ausgelegten Textureneinheiten, welche jedoch nur eine einfach ausgelegte Addressierungseinheit besitzen, nunmehr zwei Adressierungseinheiten spendiert bekamen und daher als zwei extra Textureneinheiten gewertet werden können. Demzufolge hat der G84-Chip nicht zwei Quad-TMUs, sondern gleich zwei Octo-TMUs, insgesamt also 16 Textureneinheiten. Gegenüber dem G80-Chip ist das natürlich trotzdem eine herbe Abspeckung, dieser besitzt glatt das Vierfache an reiner Rechenleistung, nämlich immerhin 128 Shader-Einheiten (16 Vec8-ALUs).

Beim Speicherinterface wird es wie schon vorab berichtet nicht mehr als ein 128 Bit DDR-Interface mit 8 ROPs geben (nVidia bindet die ROPs ans Speicherinterface) – auch hier hat der G80-Chip deutlich mehr zu bieten: Dessen 384 Bit breites DDR-Interface samt 24 ROPs ergeben das Dreifache des G84-Chips. Insofern erscheint der neue Mainstream-Grafikchip G84 doch arg beschnitten gegenüber der GeForce 8800 Serie zu sein – mit auch der Auswirkung, das sich die GeForce 8600 Serie wohl ziemlich abstrampeln wird müssen, um überhaupt gegenüber den bisherigen Mainstream-Grafikkarten bestehen zu können.

Daneben wurde noch der LowCost-Grafikchip G86 vorgestellt, dessen größte Ausführung GeForce 8500 GT das untere Ende des Mainstream-Marktes darstellen wird. Beim G86-Chip gibt es dann nur noch zwei Vec8-ALUs (16 Shader-Einheiten) mit einer Octo-TMU (8 Textureneinheiten), allerdings blieb das Speicherinterface wenigstens bei 128 Bit DDR. Allerdings sind in Form von GeForce 8300 GS und 8400 GS noch weitere G86-Ausführungen in Planung, welche dann nur noch mit 64 Bit breitem DDR-Interface antreten werden. Diese beiden letztgenannten Karten hat nVidia heute aber noch nicht vorgestellt, erst einmal kommen GeForce 8500 GT, 8600 GT und 8600 GTS in den Markt:

Wie gut zu sehen, liegt zwischen den beiden G84-Vertretern damit "nur" ein Taktunterschied von zwischen 20 und 40 Prozent, was sich aber recht gut mit dem Listenpreis-Unterschied von 33 Prozent deckt. Die GeForce 8500 GT hat hingegen nur die Hälfte der Render-Einheiten einer GeForce 8600 GT und dazu auch noch klar niedrigere Taktraten – hier dürfte wohl ein deutlicherer Performanceunterschied zu erwarten sein, als es die 50 Prozent Listenpreis-Unterschied vermuten lassen.

Leider gibt es derzeit kaum Benchmarks zur GeForce 8500 GT, primär haben sich die bisherigen Artikel zu den neuen Mainstream-Grafikkarten von nVidia mit den Modellen GeForce 8600 GT und GTS beschäftigt. Nachfolgend die Liste der derzeit im Netz diesbezüglich zu findenden Artikel:

- MSI NX6800 GTS (d) [Hard Tecs 4U]

- nVidia GeForce 8600 GTS (SLI) und 8600 GT (d) [ComputerBase]

- nVidia stellt Mainstream-DirectX-10-Serie vor (d) [Hardwareluxx]

- DX10 for the Masses: NVIDIA 8600 and 8500 Series Launch (e) [AnandTech]

- G84 takes DirectX 10 Mainstream: Foxconn GeForce 8600 GTS Review (e) [Elite Bastards]

- nVidia GeForce 8600 GTS/GT Performance Preview (e) [FiringSquad]

- GeForce 8600 GT and GTS Review and Shootout (e) [Guru3D]

- BFGTech and XFX GeForce 8600 GTS (e) [HardOCP]

- MSI GeForce 8600GTS – the new mid-range champion? (e) [Hexus]

- XFX 8600GT and 8600 GTS XXX Edition Video Cards (e) [Legit Reviews]

- Asus Extreme N6800GTS TOP (e) [Legion Hardware]

- Point of View GeForce 8600 GTS Graphics (e) [MKVTech]

- XFX GeForce 8600 GTS XXX Review (e) [Neoseeker]

- nVidia GeForce 8600 GTS Preview (e) [nV News]

- Sparkle GeForce 8600 GTS Graphics Card Review (e) [TechARP]

- nVidia's GeForce 8600 series graphics cards: DX10 goes mid-range (e) [The Tech Report]

- XFX GeForce 8600GTS XXX – nVidia's new mainstream DX10 is here! (e) [TweakTown]

Dabei kommen GeForce 8600 GT und GTS in den meisten dieser Tests zumindestens bezüglich der reinen Performance erstaunlich mittelmäßig weg. Viele Tests berichten von einer Performance der GeForce 8600 GT nur 20 Prozent überhalb der GeForce 7600 GT, währenddessen die GeForce 8600 GTS oftmals nur auf dem Niveau von Radeon X1950 Pro und GeForce 7900 GS rangiert. Dabei haben GeForce 8600 GT und GTS insbesondere ihre Probleme in Auflösungen oberhalb von 1280x1024 – auf der anderen Seite muß man sich aber auch eingestehen, das Mainstream-Grafikkarten im gewöhnlichen nicht für Auflösungen von 1600x1200 und mehr gebaut werden.

Das eigentliche Problem der GeForce 8600 GT und GTS ist dabei jedoch nicht der Abstand zur vorhergehenden Mainstream-Generation in Form von Radeon X1600/X1650 und GeForce 7600 Serie, diese Karten können die neuen Direct3D10-Beschleuniger sicherlich ausstechen. Das Problem der GeForce 8600 GT und GTS sind vielmehr die aktuell im Preisbereich von 150 bis 200 Euro angebotenen Mainstream-Beschleuniger der DirectX9-Klasse, welche unter der Haube sämtlich aus dem HighEnd-Bereich stammende Grafikchips besitzen. Gegen die technische Überlegenheit dieser Karten könnten GeForce 8600 GT und GTS allerhöchstens mit einem besseren Preis punkten, allerdings sieht die aktuelle Preislage derzeit eher umgedreht aus:

| ATIs "alte" Mainstream Grafikkarten | nVidias neue Mainstream Serie | nVidias "alte" Mainstream Grafikkarten |

|---|---|---|

| - | - | GeForce 7950 GT 256 MB ca. 220 Euro 512 MB ca. 220 Euro |

| Radeon X1950 XT 256 MB ca. 200 Euro 512 MB ca. 220 Euro |

GeForce 8600 GTS 256 MB ca. 200 Euro |

- |

| - | - | GeForce 7900 GT 256 MB ca. 180 Euro |

| Radeon X1950 Pro 256 MB ca. 150 Euro 512 MB ca. 180 Euro |

- | GeForce 7900 GS 256 MB ca. 150 Euro 512 MB ca. 170 Euro |

| Radeon X1900 GT 256 MB ca. 130 Euro |

GeForce 8600 GT 256 MB ca. 130 Euro |

- |

| - | - | GeForce 7600 GT 256 MB ca. 110 Euro |

| Radeon X1650 XT 256 MB ca. 80 Euro 512 MB ca. 90 Euro |

GeForce 8500 GT 256 MB ca. 90 Euro |

GeForce 7600 GS 256 MB ca. 80 Euro 512 MB ca. 100 Euro |

Nach der jüngsten Preisentwicklung (die GeForce 8600 GT fiel innerhalb der ersten drei Stunden nach dem Launchtermin um 15 Uhr von 150 auf 130 Euro) scheint sich die GeForce 8600 GT zumindestens nVidia-intern passabel einordnen zu können: Dem Mehrpreis gegenüber der GeForce 7600 GT steht wohl auch eine halbwegs gleiche Mehrperformance gegenüber – auch wenn man sich diese durchaus größer vorstellen könnte. Gegenüber der (allerdings nur noch selten angebotenen) Radeon X1900 GT wird es dagegen schon kritischer, da diese Karte nur geringfügig hinter einer Radeon X1950 Pro zurückliegt und schon die deutlich schneller getaktete GeForce 8600 GTS so ihre Schwierigkeiten hat, sich gegenüber dieser zu behaupten.

Die GeForce 8600 GTS hingegen erscheint zum derzeitigen Preis (welcher innerhalb der ersten Stunden nach dem Launch stabil blieb) nicht konkurrenzfähig – schließlich gibt es dafür schon eine Radeon X1950 XT, welche eigentlich durchgehend erheblich mehr Performance in die Waagschale werfen kann. Da die GeForce 8600 GTS derzeit von der Performance her ungefähr auf dem Niveau von GeForce 7900 GS/GT und Radeon X1950 Pro rangiert, müsste der Preis dieser Karte demzufolge wenigstens in die Nähe von 150 Euro absinken, um die GeForce 8600 GTS attraktiv zu halten.

Ob dies passiert, kann derzeit sicherlich trefflich spekuliert werden – schließlich gab es in der Vergangenheit mehr als ausreichend Hardware-Launches, wo sich die zum Launch angesetzten Startpreise nur wenige Wochen hielten und dann auf ein statthaftes Niveau heruntergingen. Auf der anderen Seite kann man auch genauso gut einwerfen, daß eine neue Hardware, welche schon zum Start weg kein überzeugendes Preis/Leistungsverhältnis bietet, auch mit einigen Preissenkungen niemals ein wirklich gutes Preis/Leistungsverhältnis erreichen wird können.

Insofern erscheint es ganz so, als hätte nVidia mit dem Mainstream-Direct3D-Grafikchip G84 ein gutes Stück zu kurz gegriffen bzw. den Rotstift bei den Abspeckungen zum G80-Chip zu heftig angesetzt. Dies mag womöglich auch damit zusammenhängen, daß zu Zeiten der G84-Entwicklung noch niemand ahnen konnte, das ATI und nVidia derzeit ehemalige HighEnd-Grafikchips mittels Grafikkarten für teilweise klar unter 200 Euro geradezu verschleudern. Dies wird den Markterfolg von GeForce 8600 GT und GTS gerade im OEM-Bereich natürlich kaum verhindern können, schließlich zieht dort primär Direct3D10 als Verkaufsargument. Ob sich die GeForce 8600 GT und GTS Karten allerdings im Retailmarkt gut verkaufen können, wäre vorerst zu bezweifeln – dafür sind die Leistungen der gleichpreisigen DirectX9-Konkurrenz derzeit einfach zu überzeugend.

nVidia GeForce 8800 GTX Review

Montag, 30. April 2007

Mit dem G80-Chip hat nVidia im November wie bekannt den ersten Direct3D10-Grafikchip vorgestellt, welcher auch – wie seinerzeit nicht zu erwarten war – bis jetzt der einzige entsprechende Grafikchip im HighEnd-Segment ist. Zwar hat nVidia inzwischen entsprechende Modelle für das Mainstream-Segment nachgelegt, ATI hat sein G80-Konkurrenzprojekt bis jetzt nicht offiziell vorgestellt bzw. ausgeliefert. Damit ergibt sich die ungewöhnliche Situation, daß der G80-Chip nunmehr nach runden sechs Monaten im Markt immer noch völlig allein an der Leistungspitze steht.

Zwar biegt die ATI-Konkurrenz nun langsam wirklich auf die Zielgerade ein, steht aber für diesen Artikel noch nicht zur Verfügung, welcher sich primär also damit beschäftigen wird, wie sich die GeForce 8800 GTX als Top-Modell der G80-Varianten gegenüber den vorherigen HighEnd-Lösungen positionieren kann. Daß die GeForce 8800 GTX dabei gegenüber Radeon X1950 XTX und GeForce 7900 GTX mehr oder weniger problemlos überall vorn liegen sollte, wurde natürlich auch schon mit den allerersten Artikel zu dieser Karte schnell klar.

Allerdings basieren diese Erkenntnisse im Prinzip ausschließlich auf Messungen mittels Timedemos, welche aus mehreren Gründen als reichlich ungenau bezeichnet werden können. Genauere Hintergründe hierzu liefern entsprechende Artikel hierzu, an dieser Stelle sei nur folgendes kurz ausgeführt: Bei Timedemo-Messungen fehlen im gewöhnlichen wichtige CPU-basierende Berechnungen wie die K.I. oder dynamische Physik- und Soundberechnungen. Dies ist nicht nur bei Prozessoren-Leistungstests störend, sondern betrifft auch Grafikkarten-Benchmarks, weil diese durch die abgesenkte CPU-Last teilweise deutlich höhere Frameraten als im realen Spiel auswerfen und damit auch eher in CPU-Limits laufen.

Hauptnachteil der Timedemo-Messungen ist aber, daß hiermit nur Durchschnittswerte von zumeist längeren Benchmark-Durchläufen ausgegeben werden (oder aber Minimalwerte von einzelnen Zehntelsekunden, was genauso nichtssagend ist). Damit läßt sich sicherlich ermitteln, welche Grafikkarte prinzipiell schneller ist – eine Aussage zur Spielbarkeit kann damit jedoch nicht getroffen werden. Man nimmt gewöhnlich an, daß ein Durchschnittswert von 40 fps ausreichend ist und damit auch die langsamen Szenen noch überhalb von 25 fps liegen sollten. Dies bleibt jedoch immer nur eine Annahme: Denn um zu einem Durchschnittswert von 40 fps zu kommen, kann das eine Spiel in der Tat zwischen 25 und 60 fps schwanken – ein anderes aber auch zwischen 10 und 100 fps.

Das Prinzip der Durchschnittsframeraten-Messungen wird diesem also selber zum Verhängnis, da bei einer solchen Messung eben nie festgestellt werden kann, wie die einzelnen Grafikkarten die wirklich Performance-kritischen Stellen bewältigen. Wenn man wirklich wissen will, wie es ausschaut, wenn die Frameraten nach unten gehen und die Hardware wirklich gefordert wird, muß auch auch nur genau das ausmessen – mittels kurzen Savegames von besonders performance-kritischen Stellen im Spiel. Erst mit diesen Messwerten in der Hand läßt sich dann auch sagen, welche Settings eine Grafikkarten noch verträgt – und welche nicht mehr.

Solcherart Benchmarks entsprechen damit auch dem, was der Spieler letztlich im Alltagseinsatz selber so macht: Die Orientierung der Spielsetting nicht an der (meist problemlosen) Durchschnittsperformance, sondern bewußt an den langsamen Stellen im Spiel. Kaum jemand stellt sein Spiel auf solcherart Settings, welche dem Spieler zwar gewöhnlich 40 garantieren, in bestimmten Szenen jedoch auf unter 15 fps einbrechen – in einer solchen Situation wird man wohl meistens seine Settings überdenken. Genau diesem Verhalten aus der Praxis sind auch unsere nachfolgenden Benchmarks geschuldet: Vermessen werden soll nicht eine Durchschnittsperformance, sondern das, was übrig bleibt wenn die Grafikkarten wirklich gefordert sind.

Dazu wurde wie gesagt auf Timedemo-Messungen verzichtet und komplett auf Savegames gesetzt. Jedes einzelne Savegame enthält dabei nur eine kurz Sequenz von drei bis fünf Sekunden mit einer wirklich Hardware-fordernden Spielszene, deren Durchschnittswerte mittels Fraps (in jeweils drei Messungen) ermittelt wurden. Da zudem eine einzelne kurze Spielszene nur eine äußerst beschränkte Aussage zu den wirklichen Performance-Tiefstpunkten im Spiel geben kann, wurden für jedes Benchmark-Spiel gleich ganze vier Savegames angesetzt. Dieses Testverfahren ist insgesamt betrachtet äußerst aufwendig, erscheint uns aber derzeit als beste bekannte Möglichkeit, Grafikkarten nicht nur nach der Frage von "schneller oder langsamer", sondern auch nach der Frage "spielbar oder nicht spielbar" austesten zu können.

Vorab sei an dieser Stelle den Firmen Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel ermöglicht wurde. Ausdrücklicher Dank gilt zudem der Firma Asus für die Teststellung der titelgebenden GeForce 8800 GTX.

Die neuen Desktop-Lineups von ATI und nVidia

Donnerstag, 24. Mai 2007

/ von

Leonidas

Im Zuge des Launches der Radeon HD 2900 XT kündigte ATI auch das Erscheinen der Radeon HD 2400 und 2600 Serien im Juni an, selbst wenn die Daten zu diesen Karten tief in den Launch-Präsentationen vergraben waren und daher kaum beachtet wurden. In der Tat hatte man natürlich von ATI einen vollständigen Launch aller dieser Grafikkarten erwartet – und als dieser ausblieb, konzentrierte man sich eben vollständig auf die Radeon HD 2900 XT bzw. den R600-Chip.

Nichts desto trotz liegen die Daten zu den Radeon HD 2400 und 2600 Karten seitens ATI vor, womit nun beide Grafikchip-Entwickler ein vollständiges Direct3D10-Produktprogramm am Markt bzw. zumindestens sicher angekündigt haben. Die Aufgabe der kommenden Zeilen und Gegenüberstellungen wird nunmehr sein, das jeweilige Direct3D10-Programm der beiden Hersteller vollständig in Zahlen und Worte zu fassen, wie aber auch preislich eventuell interessante Überschneidungen zum noch im Markt befindlichen DirectX9-Angebot aufzuzeigen.

Anmerkungen: Alle genannten Straßenpreise basieren auf dem Stand 23. Mai 2007 frühmorgens und dürften sich im Laufe der folgenden Tage und Wochen natürlich immer weiter nach unten verschieben. Alle Bandbreitenangaben wurden zudem nach der 1024er Regel errechnet, als Maßeinheit hierfür wurde allerdings das altherkömmliche Gigabyte/Sekunde benutzt, nicht das neuere, in der Industrie jedoch nach wie vor unübliche Gibibyte/Sekunde.