ATI Radeon HD 2900 XT Review

Am heutigen Tage ist es endlich soweit – sechs Monate nach dem Launch der Direct3D10-Generation von nVidia bringt der nunmehr zu AMD gehörende Grafikchip-Entwickler ATI den R600-Chip und damit seinen ersten Direct3D10-Grafikchip auf den Markt.

Genau wie der G80 handelt es sich beim R600 um eine Grundarchitektur der dritten Generation (wenn man ab der GeForce 256 und der Radeon 256 anfängt zu zählen). Die Lebzeit der ersten Generation beschränkt sich bei ATI auf den R100 (Radeon 256) und den RV200 (Radeon 7500). Kurze Zeit später folgte die zweite Generation: Der R200 (Radeon 8500) legte den Grundstein für die erfolgreiche R300 (Radeon 9500/9700) und deren Nachfolger. Im Jahre 2004 sollte dann ursprünglich die dritte Generation – der R400 – erscheinen.

Aus verschiedenen Gründen wurde dieser Chip jedoch storniert, ein Derivat des R400 landete letzten Endes in Form des Xenos in der Xbox 360. Dieser bildete die erste Unified Shader Generation der 3D-Beschleuniger-Chips in der 3D-Geschichte. Einiges von dessen KnowHow floss letztlich in die Chips R520/R580 (Radeon X1800/X1900) ein, welche noch großteils auf der zweiten Generation beruhten.

Der R600 ist nunmehr sozusagen eine starke Weiterentwicklung des R400. Da man bei ATI auf eine mehrjährige Erfahrung mit Unified Shadern zurückgreifen konnte, haben sich natürlich vielerlei Dinge seit dem R400 getan. Die Skalierbarkeit, die Flexibilität der Rechenwerke, die nötigen Features für Direct3D10 als auch die Rohleistung wurden gesteigert.

Nach langer Zeit erhält 3DCenter wieder einmal die Möglichkeit, einen Launch-Artikel zu präsentieren. Vorab sei an dieser Stelle den Firmen AMD [4] (ATI, Radeon HD 2900 XT), Listan [5] (beQuiet, 600W-Netzteil zum stabilen Betrieb der neuen ATI-Karte) und Club3D [6] (GeForce 8800 GTX) für die unkomplizierte Stellung von Testsamples für diesen Artikel gedankt.

Ausdrücklicher Dank gilt zudem der Firma PC-Spezialist [7] in Stralsund. Denn beinahe wäre dieser Artikel doch noch ins Wasser gefallen, da vergangenen Freitag unser Mainboard nach einem Bluescreen seinen Dienst quitierte. In letzter Sekunde konnte man uns allerdings ein Ersatzmainboard (gleich mit CPU) unkompliziert leihen.

Die Testkandidaten im Vergleich

700 Millionen Transistoren, 740 MHz Kerntakt und ein 512 Bit DDR Speicherinterface – das klingt nach einer echten Grafikkarte für Männer. Was diese in der Praxis kann, soll dieser Artikel vermitteln. In der folgenden Tabelle sind die Kernzahlen des R600-Chips im Vergleich zum G80-Chip sowie dem ATI-Vorgänger R580 kurz aufgelistet:

| ATI Radeon X1900 XT | ATI Radeon HD 2900 XT | nVidia GeForce 8800 GTX | |

|---|---|---|---|

| Chip-Basis | ATI R580, 384 Millionen Transistoren in 90nm bei TSMC | ATI R600, 700 Millionen Transistoren in 80nm bei TSMC | nVidia G80, 681 Millionen Transistoren in 90nm bei TSMC |

| Technologie-Klasse | DirectX 9.0c, Shader Model 3.0 | Direct3D10, Shader Model 4, Unified Shader Architektur | Direct3D10, Shader Model 4, Unified Shader Architektur |

| grundlegende Technik | 16 Rendering-Pipelines mit jeweils drei Pixelshader-Einheiten (insgesamt 48 Pixelshader-Einheiten), dazu 8 Vertexshader-Einheiten, 16 ROPs, 256 Bit DDR Speicherinterface (8x32 Bit) | 64 Shader-Einheiten, 16 Textureneinheiten, 32/64 ROPs, 512 Bit DDR Speicherinterface (8x64 Bit) | 128 Shader-Einheiten, 32/64 Textureneinheiten, 24 ROPs, 384 Bit DDR Speicherinterface (6x64 Bit) |

| Taktraten | 625/750 MHz | 740/825 MHz | 575/900 MHz Shader-Einheiten: 1350 MHz |

| Bauform | 256 oder 512 MB GDDR3, PCI Express, DualSlot, vollständig HDCP-kompatibel | 512 MB GDDR3, PCI Express, DualSlot, vollständig HDCP-kompatibel | 768 MB GDDR3, PCI Express, DualSlot, vollständig HDCP-kompatibel |

Der Verkaufsname des R600-Chips ist Radeon HD 2900XT. Das impliziert neben einer Leistungssteigerung eine deutliche Orientierung auf den HighDefinition-Trend der Unterhaltungsindustrie. Der Videoprozessor des R600-Chips unterstützt eine vollständige Beschleunigung von HD-Videocodecs wie dem h.264-Verfahren, bisher mussten rechenintensive Teile der Encodierung noch von der CPU übernommen werden.

Weiterhin hat die Radeon HD 2900 XT eine Funktion als Soundkarte. Über einen DVI Adapter kann ein Videosignal als auch ein Audiosignal auf den digitalen HDMI-Multimediaanschluss geschliffen werden. Hinzu kommt, dass die Karte auch einen eigenen Realtec Soundcodec-Chipsatz an Board hat. Dieser unterstützt eine digitale Soundausgabe von bis zu 8 Kanälen (entspricht 7.1 Sound). Somit sind die kleineren Brüder der Radeon HD 2900 XT (in Form der Radeon HD 2400/2600 Serien) möglicherweise eine gute Wahl für Mediacenter-PCs.

Schon lange vor dem Start des R600-Chips gab es reichlich Gerüchte über einen teilweise sagenhaft hohen Stromverbrauch dieses Grafikchips. Dem sind wir natürlich mit extra Messungen zur Leistungsaufnahme nachgegangen. Dafür verwendeten wir ein digitales Strommessgerät unseres lokalen Stromanbieters. Damit lässt sich natürlich nur die Gesamtleistungsaufnahme des Testsystems feststellen, jedoch kann damit eine ungefähre Differenzbetrachtung ermöglicht werden.

Für die Messungen haben wir den Verbrauch des Systems im Windowsbetrieb, bei ausgelasteten CPU-Kernen (2x Prime) und bei vollends ausgelastetem System (Last auf Grafikkarte und 2x Prime) gemessen. Damit die herstellerspezifische CPU-Last durch den Treiber die Werte nicht verfälscht, haben wir im Hintergrund jeweils zwei Prime-Instanzen gestartet. Diese nutzen jedes Quäntchen übrigbleibender CPU-Leistung, haben jedoch eine deutlich geringere Prozesspriorität als andere Anwendungen und schmälern die CPU-Leistung in Spielen nicht. Als 3D-Anwendung kam der Canyon Flight im 3DMark06 auf 1680x1050, 4xMSAA und 16xAF zum Einsatz.

| Windows | Last auf CPU | Last auf CPU und GPU | |

|---|---|---|---|

| Radeon X1950 XT | 124W | 183W | 281W |

| Radeon HD 2900 XT | 161W | 220W | 319W |

| GeForce 8800 GTX | 161W | 221W | 291W |

Wie man klar erkennen kann, funktioniert nur der 2D-Modus der Radeon X1900 XT wirklich gut. Wie auch die GeForce 8800 GTX scheint die Radeon HD 2900 XT dagegen im 2D-Modus massig an Energie zu verbrauchen, aufgrund der identischen Messergebnisse müssten dies bei beiden Grafikkarten dementsprechend satte 70 Watt Stromverbrauch im Idle-Modus sein. In Spielen nimmt das R600-Board dann noch einmal bis zu 30 Watt mehr Leistung auf als das G80-Board. Die Leistungsaufnahme der Radeon HD 2900 XT im 3D-Modus scheint also bei runden 170 Watt zu liegen.

Im Windowsbetrieb sind alle Karten durchaus sehr leise. Startet jedoch ein Computerspiel, so trennt sich die Spreu vom Weizen: Die GeForce 8800 GTX bleibt hier noch vergleichsweise ruhig, lediglich ein Zwitschern und Pfeifen störte die Ruhe ein wenig. Die Radeon X1900 XT ist da schon etwas lautstärker. Die Radeon HD 2900XT hingegen übertrifft dies nochmals deutlich, ähnlich dem Geräusch eines aufdrehenden CD-ROM Laufwerks dreht der Lüfter hoch. In diesem Punkt kann man nur darauf hoffen, dass AMD noch an der Lüftersteuerung der Radeon HD 2900 XT nacharbeitet oder das Hersteller wie Club3D eine leisere, eigene Kühllösung auf den Markt bringen.

Der R600-Grafikchip

Der R600-Chip verfügt über vier SIMD Quad-Pipelines, welche jeweils mit 16 ALUs bestückt sind, jede ALU verfügt dabei über fünf Komponenten. Wie auch nVidia beim G80-Chip spricht ATI hierbei von einem skalaren Aufbau der Pipelines. Genau genommen entspricht das jedoch nicht der Wahrheit. Der SFU-Kanal arbeitet tatsächlich "vertikal" skalar. Der Vec4-Teil der ALU, hier als RGBA aufgeführt, ist eine "horizontale" SIMD-Einheit. Um zu verstehen, was daran besonders ist, werfen wir einen Blick auf eine ALU aus der letzten Generation (z.B. Xenos):

Als Input kommen hintereinander vier Pixel (in vier Takten) mit bis zu vier Komponenten und einer SFU (z.B. Sinus, Cosinus, Reziproke ect) in die ALU. Pro Takt berechnet die ALU also einen Pixel mit allen Komponenten. Der Nachteil dieser Methode ist offensichtlich: Nicht immer gibt es pro Takt und Pixel genügend Instruktionen, um alle Kanäle zu füllen. Die Einheiten werden also im Durchschnitt nicht optimal ausgelastet.

Die neuen R600-ALUs arbeiten hingegen anders. Als Input fallen pro Takt gleichzeitig vier Pixel an. Wie zuvor in der Abbildung dargestellt, braucht die Xenos-ALU jedoch bis zu vier Takte, um die Berechnungen für die vier Pixel durchzuführen – nacheinander werden alle Kanäle der vier Pixel berechnet. Die neue skalare SFU-ALU springt hingegen von Takt zu Takt zu den Registern der unterschiedlichen Kanäle hin und her. Am Ende sind auch die bis zu vier zugehörigen skalaren SFUs fertig.

Der Vorteil dieser Methode ist dann gegeben, wenn weniger unabhängige Instruktionen pro Takt und Pixel anfallen, als Kanäle verfügbar sind. In diesem Falle rechnet die ALU so lange, bis die Rechenoperation der vier Pixel benötigt wird. Es kann also Rechenzeit gespart werden, die Auslastung der ALUs ist somit besser.

Allerdings hat diese Methode den Nachteil, dass die Kontrolllogik deutlich mehr Transistoren kostet. Im Gegensatz zum G80-Chip hat man hier beim R600-Chip etwas gespart und gleich 16 dieser ALUs in einem SIMD verschaltet. Die Granularität und damit auch die Effizienz sinkt damit. Im Gegenzug konnte man jedoch eine höhere Anzahl an Rechenwerken verbauen. Der G80-Chip nutzt hier einen Trick aus der Fertigung, der bei CPUs gang und gebe ist: Durch "handoptimierte" Transistoren kann nVidia die ALUs deutlich höher takten.

| ATI Radeon HD 2900 XT | nVidia GeForce 8800 GTX | |

|---|---|---|

| MAD Leistung | 473 GFlops/sec | 345 GFlops/sec |

Der R600-Chip scheint eine deutlich höhere MAD-Rohleistung zu haben. Zieht man allerdings die skalaren SFUs ab (welche beim G80-Chip durch die MUL-ALU erledigt werden), können diese kein MAD mehr zur Rechenleistung beisteuern. Dann ist die rechnerische Endleistung bei beiden Chips beinahe gleich. Wie die effektive Rechenleistung zustande kommt, ist eine reine Designentscheidung. Die Balance zwischen einer Vielzahl günstiger ALUs und einer geringeren Anzahl komplexer und effektiver ALUs entscheidet über die Endleistung.

Ein Beispiel: Der R580-Chip hat eine theoretische MAD-Rechenleistung von 306 GFlops/sec, die Vertexshader-Leistung wurde dabei miteinbezogen. Der G80-Chip hat hingegen eine theoretische MAD-Rechenleistung von 345 GFlops/sec. Letzterer verfügt jedoch dank seiner guten Auslastung in etwa über die doppelte effektive Rechenleistung.

Damit die teuer erkauften ALUs nicht auf profane Dinge wie die Texturfilterung warten müssen, muss genug Texturfüllrate vorhanden sein. Der R600-Chip bietet pro Takt 16 bilinear gefilterte Texel an. Das klingt zunächst nach keiner Steigerung gegenüber dem Vorgängermodel. Jedoch wurde der R600-Chip für HDR-Rendering entworfen. Die TMUs brechen im Gegensatz zu den G80-TMUs nicht durch die Filterung von Texturen ein, die im FP16-Format vorliegen. Auch das Speicherinterface bietet dank der 512-Bit-Anbindung genug Bandbreite für FP16-Texturen und den FP16-Framebuffer. Natürlich beherrschen die neuen TMUs auch das FP32-Texturformat. Dies ist dann allerdings mit einer Halbierung der Füllrate verbunden.

| ATI Radeon HD 2900 XT | nVidia GeForce 8800 GTX | |

|---|---|---|

| FX8 bilinear | 11840 Mtex/s | 18400 Mtex/s |

| FX8 trilinear | 5920 Mtex/s | 18400 Mtex/s |

| FP16 bilinear | 11840 Mtex/s | 18400 Mtex/s |

| FP16 trilinear | 5920 Mtex/s | 9200 Mtex/s |

Wie man sieht, ist die Rohfüllrate des R600-Chips in allen Fällen geringer. Allerdings ist hier noch nicht mit einberechnet, dass der R600-Chip noch über 16 zusätzliche Pointsampling-TMUs verfügt. Diese werden für Pixel- und Vertexfetches genutzt. In zukünftigen Applikationen kommen noch Berechnungen von komplexeren Matrizen oder 2D-Kernel-Filter hinzu. All dies benötigt keine gefilterten Texturwerte und kann somit auf die Point-Sampling-TMUs ausgelagert werden. Das schmälert die effektive Füllrate des R600-Chips dann nicht – im Gegensatz zum G80-Chip.

Die Texturcaches des R600 belaufen sich auf 1x 256 kiB für den Level2-Cache sowie 4x 32 kiB für die Level1-Caches und sind damit ungewöhnlich groß bemessen. Inwiefern das die effektive Texturfüllrate verbessert, ist uns jedoch nicht bekannt. Am Ende des Tages ist die effektive Füllrate des R600-Chips auch unter HDR-R Bedingungen nicht von schlechten Eltern, jedoch ist sie der Füllrate eines G80-Chip im Vollausbau nicht gewachsen.

Um die berechneten Pixel auch auf die Straße bringen zu können, wurden die ROPs des R600-Chips deutlich aufgebohrt. Der R600 besitzt 64 Z/Stencil Units. Allerdings kann er maximal 32 Z/Stencil Werte pro Takt in den Framebuffer schreiben. Jedoch können die ROPs dennoch nebenbei für HSR und Farbe genutzt werden. Bei bis zu einem vierfachen Multisampling Anti-Aliasing bricht die ROP-Leistung also nicht unter die Pixelfüllrate von 16 Pixeln pro Takt ein. Damit ist der R600-Chip wie auch der G80-Chip für die Nutzung von vierfachem Anti-Aliasing optimiert.

Natürlich ist die ROP-Leistung des G80 mit 192 Z-Compare Units deutlich höher als die ROP-Leistung des R600. Dies dürfte in Spielen jedoch relativ selten zum Tragen kommen. Einerseits lastet der R600-Chip die ROPs wahrscheinlich weniger aus, da er über weniger Rohtexelfüllrate verfügt als der G80, und andererseits kostet ein ROP-Loop nur einen Takt. Verglichen mit dem dreistelligen Taktbereich zur Berechnung eines Pixels ist das verschwindend gering.

Das neue Anti-Aliasing

Jahre nach der Vorstellung des R300-Chips (Radeon 9500/9700) bohrt ATI beim R600-Chip das Raster des Trisetup von einer 12x12 Maske auf eine 16x16 Maske auf. Damit ist nun ein achtfaches Sparsed Grid Multisampling Anti-Aliasing, kurz SG-MSAA, möglich. Dank dem 512 Bit breiten Speicherinterface kann dieses auch mit akzeptabler Leistung umgesetzt werden.

Völlig neu hingegen ist das "Custom Filter Anti-Aliasing" (CFAA). Das Funktionsprinzip ist hierbei simpel: Mittels eines Shaders werden einfach bis zu 12 Subsamples von Nachbarpixeln "geborgt", das kostet schließlich kaum extra Rechenleistung und Bandbreite. Doch kennen wir das nicht irgendwoher? Klar, der "Weichzeichner" Quincunx seitens nVidia wird dem Leser jetzt durch den Kopf schiessen. Doch das ist so nicht ganz korrekt: Das Einbeziehen von Informationen von Nachbarpixeln durch CFAA führt zu einem gewissen Blurfilter, welcher aber in der Praxis deutlich geringer ist als beim Quincunx-Verfahren.

Der Filterkernel nutzt nämlich nur Randsubpixel der Nachbarsamples, der Blureffekt ist also deutlich kleiner. Man hat zusätzlich zur Anti-Aliasing Stufe die Wahl zwischen drei Filterarten: Narrow Tent, Wide Tent und Edge Detection. Der Wide Tent Filter bezieht mehr Subpixel von Nachbarpixeln ein als der Narrow Tentfilter, dies bedeutet allerdings auch einen stärkeren Blureffekt. Wir halten den Nutzen dieser beiden Filter für fragwürdig, da man somit zwar einen stärkeren Kantenglättungseffekt hat, jedoch die hart erarbeiteten Texturen-Bildinformationen wieder ruiniert werden. Dafür kosten diese Modi aber auch nur sehr wenig Performance.

Edge Detection hingegen wendet das Blur-Verfahren gezielt da an, wo es sinnvoll ist. Dazu wird das Bild nachträglich nach Polygonkanten abgesucht. Das geschieht, indem man sich die Eigenheit des Multisampling-Verfahrens zunutze macht: Pixel für Pixel werden über die ROPs in die Shader eingelesen. Diese vergleichen dann die Farbinformation der Subpixel: Ist die Subpixelfarbe der Samples pro Pixel gleich, so handelt es sich nicht um eine Polygonkante und CFAA wird nicht angewendet. Unterscheiden sich die Farbwerte hingegen, so wird CFAA angewandt.

Diese Resolvefunktionen im Shader sind natürlich nicht kostenlos. Es kostet Rechenleistung, ein wenig Bandbreite und ROP-Leistung. Da wir dieses "Edge Detection" Verfahren als sinnvoll erkannten und wie bereits erwähnt von der resultierenden Bildqualität positiv überrascht sind, verwendeten wir dieses Verfahren in unseren Benchmarks gegen das Coverage Sample Verfahren von nVidia. Das CFAA ist allerdings auf den Radeon-Karten der Vorgängergeneration nicht nutzbar, da dessen ROPs nicht die Fähigkeit besitzen, Samples an die Shader zu übergeben.

Da der Edge Detection Modus erst seit dem 8.3742er Treiber, welcher erst seit letztem Freitag verfügbar ist, über ein separates Tool aktivierbar ist, gehört 3DCenter vermutlich zu den wenigen Redaktionen, die diesen Modus überhaupt testen können. Das Fazit im Bildqualitäts- und im Benchmarkteil ist somit natürlich ein völlig anderes.

Ein weiterer Treiber-Fauxpas scheint andere Testredaktionen ebenfalls zu treffen: Im früheren 8.3740er Treiber war das Adaptive Anti-Aliasing laut ATI von einem Bug betroffen, welcher den R600-Chip enorm an Performance kostete. Laut unseren Beobachtungen und Messungen wurde erst in dem von uns verwendeten Treiber AAA durch ein Multisampling-Verfahren (genannt EATM) ersetzt. Dabei ist die Bildqualität für einen solchen Multisampling-Modus sehr gut, jedoch läßt derzeit die Kompatibilität noch zu wünschen übrig. Aus diesen Gründen hielten wir Leistungsmessungen mit Transparenz Anti-Aliasing zu diesem Zeitpunkt nicht für sinnvoll und haben dieses Feature nachfolgend auch nicht bei unseren Benchmarks eingesetzt.

Technikvergleich Anti-Aliasing (ATI)

Vor den eigentlichen Benchmarks wollen wir uns zuerst mit Anti-Aliasing und anisotropen Filter der beiden großen Grafikchip-Entwickler beschäftigen – bzw. in erster Linie, wie gut diese überhaupt miteinander vergleichbar sind. Denn natürlich sind Vergleich rein anhand des Namens nicht wirklich seriös – ein "4xAF" bei dem einem Hersteller kann bei einem anderen Hersteller etwas ganz anderes bedeuten, schließlich gibt es diesbezüglich keine für alle Hersteller verbindliche Namenskonvention. Vor einem Leistungsvergleich steht daher erst einmal der Optikvergleich, um zu sehen, was man da überhaupt gegeneinander ausmisst.

Mittels der neuen Grafikchips ATI R600 und nVidia G80 bringen beide Grafikchip-Entwickler neben den bereits bekannten Anti-Aliasing Modi eine Reihe weiterer Varianten ins Spiel, welche zudem teilweise auch auf neuen Anti-Aliasing Technologien basieren. Wir werden an dieser Stelle allerdings noch keine vollständige technische Abhandlung über ATIs "Custom Filter Anti-Aliasing" und nVidias "Coverage Sample Anti-Aliasing" liefern können, dies wird Aufgabe kommender Artikel sein.

Demzufolge haben wir es an dieser Stelle erst einmal bei der reinen Auflistung der einzelnen angebotenen Modi belassen. Anzumerken wäre, daß wir uns bei der Filterqualität rein auf den unter Direct3D laufenden FSAA Tester [9] verlassen haben, da bei beiden Grafikchip-Entwicklern unter den normalen Anti-Aliasing Modi keine Unterschiede mehr zwischen Direct3D und OpenGL existieren:

ATIs Anti-Aliasing Modi bei der Radeon HD 2x00 Serie basieren prinzipiell auf denen der Radeon X1x00 Serie, die höheren Modi hat ATI allerdings komplett neu gestaltet. So gibt es nun ein 8x Anti-Aliasing anstatt des bisherigen 6x Anti-Aliasings, zudem wurden einige "Custom Filter Anti-Aliasing" Modi hinzugefügt:

Wir listen obenstehend von den CFAA-Modi aber nur die höchste Variante mit "Edge Detection" auf, da die darunterliegenden Varianten mit "Narrow Tent" (benutzt aus den vier umliegenden Pixeln jeweils ein Sample) und "Wide Tent" (benutzt aus den vier umliegenden Pixeln jeweils zwei Samples) in dem Sinne Blurfilter (Weichzeichner ähnlich nVidias Quincunx) sind, was nicht dem Grundgedanken von Anti-Aliasing entspricht.

Technikvergleich Anti-Aliasing (nVidia)

Selbige Auflistung ergeht nun auch für nVidias GeForce7-Serie, wobei hier wie üblich der 2x Quincunx Modus herausgelassen wurde, da dieser nicht der eigentlichen Definition von Anti-Aliasing entspricht, sondern ein klassischer Weichzeichner ist (mit welchem vornehmlich Texturinformationen weichgezeichnet und damit zerstört werden):

Und letztlich kommt nun noch der G80-Chip an die Reihe, welcher wie der R600-Chip auch einige neue Anti-Aliasing Modi mitbringt:

Wie zu sehen, hat nVidia oberhalb des 4x Modus einiges geändert: Sämtliche Hybrid-Modi zwischen Multisampling und Supersampling Anti-Aliasing sind beim G80-Chip nicht mehr mit dabei, dafür gibt es nunmehr ein vollwertiges 8x Sparsed Grid Multisampling Anti-Aliasing, welches in der Kantenglättungsqualität ATIs "alte" 6x Lösung sogar minimal überflügeln kann (sehr viel besser kann es nicht werden, weil mit steigender Samplingzahl die jeweiligen Bildqualitätsgewinne relativ gesehen deutlich geringer werden).

Zudem gibt es ein neuartiges "Coverage Sample Anti-Aliasing", welches mit nur einem geringen (relativen) Leistungsverlust auch hohe Anti-Aliasing Modi ermöglichen soll. Dazu benutzt der nVidia-Treiber bei den Coverage Sample Anti-Aliasing Modi eine geringere Anzahl an Farb- und Z-Werten als normalerweise, womit in erster Linie Speicherbandbreite gespart wird, was bei hohen Anti-Aliasing Modi im gewöhnlichen der größte Bremsklotz ist. In der Summe kommt Coverage Sample Anti-Aliasing damit mit einem Bruchteil der Leistungsanforderungen aus, als wenn man dieselbe Sampleanzahl in einem reinem Multisampling berechnen wollte.

Dafür funktioniert Coverage Sample Anti-Aliasing allerdings nicht in jeder Anwendung – so beispielsweise nicht mit den in F.E.A.R. benutzten Stencil-Schatten. Positiverweise fällt in einem solchen Fall nicht gleich das komplette Anti-Aliasing aus, sondern vielmehr wird immer noch der gewöhnliche Multisampling-Teil dargestellt, welchen die Coverage Sample Anti-Aliasing Modi immer mit enthalten.

Praxisvergleich Custom Filter & Coverage Sample Anti-Aliasing

Nachfolgend wollen wir uns den beiden neuen Anti-Aliasing Arten der beiden Grafikchip-Entwickler genauer widmen. Um möglichst alle Modi in einem Spiel vergleichen zu können, soll uns daher The Elder Scrolls IV: Oblivion als Testkandidat dienen. Um den Vergleich so deutlich wie möglich darzustellen, haben wir uns für eine Stelle mit hohem Kontrast entschieden. Beim CFAA bei ATI wählten wir (wie vorstehend schon erwähnt) ausschließlich den Edge Detection Filter. Zur Erklärung unerer Nomenklatur:

- R600: 4xMS+CFAA = 12xAA bzw. 8xMS+CFAA = 24xAA

- G80: 4xMS+CSAA = 8xAA bzw. 8xMS+CSAA = 16xQ

Leider sind die Screenshots nicht pixelgenau gleich geworden, obwohl sie unsererseits korrekt abfotographiert wurden. Womöglich aber unterstützt das Spiel selber eine pixelgenaue Positionierung der Spielfigur bzw. der Spielobjekte nicht, anders können wir uns dies derzeit auch nicht erklären.

[30]

[30]ATI 4xMS+CFAA (MouseOut) vs. normales 4xMS (MouseOver) [30]

Den Nutzen von CSAA und CFAA erkennt man in diesem Fall sofort: Die beiden neuen Verfahren von ATI und nVidia liefern hier ein besser abgestuftes Bild. Im direkten Vergleich scheint das Custom-Filter-Verfahren von ATI jedoch die weicheren Übergänge zu erzeugen.

In dieser Konstellation wollen wir überprüfen, wie gut sich der beste 4fach Modus gegenüber dem neuen 8fach Multisampling schlagen kann. Man erkennt zwar die höhere Anzahl an Samples beim 8xMS, sieht aber auch die homogenere Abstufung beim Custom Filter Anti-Aliasing mit nur vier echten Samples. Es wird in der Praxis sowohl Stellen geben, an denen die höhere Anzahl an Samples ihren Vorteil ausspielt, als auch die eine oder andere Stelle, an denen ATIs bester 4fach Modus punkten kann.

Gegenüber dem bereits bekannten Screenshot mit 8x Multisampling kann sich nVidias Coverage Sample Anti-Aliasing sichtbar absetzen. Den großen Pokal darf sich aber definitiv ATI abholen: Was hier im Zusammenspiel von acht Samples und dem Custom-Filter erreicht wird, ist bisher einfach ungeschlagen. Die Abstufungen sind schon fast fließend und dürften, mehr als alle anderen verfügbaren Modi, für ein sichtbar besseres Bild sorgen.

Praxisvergleich Adaptive & Transparenz Anti-Aliasing

Multisampling, Coverage Sampling, Custom Filter ... alle diese Verfahren teilen sich allerdings ein großes Problem: Keines der Bilder zeigte irgendeinen sichtbaren Glättungseffekt für Alphatexturen, wie beispielsweise für Bäume und deren Blätter. In Bewegung führt das zu hässlichem Flimmern und sichtbaren Treppeneffekten. Um diesem Problem beizukommen, bieten die Konkurrenten dem User noch eine zusätzliche Option an – das Transparenz Anti-Aliasing.

Das Vergleichsbild zeigt zwei Bäume, welche ihre Blätter prachtvoll in den Himmel erheben. Im Normalfall kommt beim Spieler davon jedoch nicht mehr so viel an: Wie leicht zu sehen ist, lösen sich die Blätter ohne Transparenz Anti-Aliasing in Pixelbrei auf – unkontrolliertes Flimmern (vor allem in Bewegung) ist die Folge. nVidias performante Lösung dafür findet sich in einem Multisampling-Filter, welcher den Pixelbrei glätten soll. Es zeigt sich dabei auch ein wesentlich ruhigeres Bild, bei dem sichtlich mehr "Informationen" erhalten bleiben. Doch nicht in jedem Fall ist dieser Modus gut genug, um einen rundum zufriedenstellenden Effekt zu erzielen.

nVidia bietet deshalb auch einen Modus im Supersampling-Verfahren an. Die dafür zusätzlich benötigte Performance wird genutzt, um einen größeren Bereich zu glätten und gleichzeitig mehr vom eigentlich gewünschten Bild darzustellen. Der leichte und nicht störende "Blur"-Effekt sorgt in der Praxis für ein wesentlich ruhigeres Bild, bei dem entsprechend mehr Details erkennbar bleiben.

ATIs Lösung beim R600-Chip arbeitet prinzipiell nach dem gleichen Prinzip: Hässliches Flimmern soll verhindert werden und die Treppenstufen am besten ganz getilgt. Beim R600-Chip kommt ein Verfahren namens "EATM" zum Einsatz, welches über die Windows-Registry auch schon mit früheren ATI-Chips nutzbar ist. Egal wie die Methode heißt, das Ziel wird auf jeden Fall erreicht: Die Bildqualität steigt sichtlich an, legt gegenüber dem Verfahren von nVidia sogar noch eins drauf. Dem Spieler erscheinen Baumkronen und Blätteransammlungen generell als fülliger und dichter.

Das wird schon allein an der Dateigröße des hier dargestellten Screenshots ersichtlich. Statt 186 kByte gönnt dieser gleich sich über 300 kByte. Somit kann ATI in diesem Vergleich das von der Bildqualität anscheinend beste Verfahren anbieten. Wirklich überzeugt sind wir jedoch noch nicht, da EATM in der Vergangenheit mit Kompatibilitätsproblemen zu kämpfen hatte. Der vom R580-Chip bekannte, schlechtere Adaptive-Modus, scheint derweil beim R600 noch nicht zu funktionieren.

Technikvergleich anisotroper Filter

Nach der Betrachtung der Möglichkeiten von ATI und nVidia beim Thema Anti-Aliasing folgt nun selbiges zum Thema des anisotropen Filters – welches mit dem grundsätzlichen Unterschied gewürzt ist, daß man hierzu eigentlich ganze Bücher an Material füllen könnte. Denn hier spielen nun neben unterschiedlichen Settings und Wertigkeiten nun auch noch die beliebten Filter-"Optimierungen" mit hinein, steigt die Komplexität eines Vergleichs also enorm an, wollte man alle diese Optionen berücksichtigen.

Deshalb haben wir uns dazu entschlossen, nur noch die wichtigsten und am häufigsten genutzten Optionen anzusprechen – letztlich geht es schließlich immer darum, was in der Praxis mehrheitlich passiert und nicht, was rein theoretisch alles möglich wäre. Demzufolge enthält die nachfolgende tabellarische Aufstellung nunmehr auch nur Screenshots von 4x und 16x anisotropen Filter: Das 4x, weil hierbei die verschiedenen Ansätze noch am besten zu sehen sind, und das 16x, weil bei diesem die teilweise arg geringen Unterschiede zwischen den niedrigen und den hohen AF-Modi gut zur Geltung kommen.

Gleichfalls beschäftigt sich die nachfolgende Aufstellung auch nur noch mit dem anisotropen Filter per Aktivierung aus der

Anwendungssoftware (dem Spiel) heraus, nicht mehr mit dem anisotropen Filter per Aktivierung aus dem Control Panel des Herstellers. Dies hat vor allem früher noch sehr unterschiedliche Filterqualitäten ergeben, da bei Aktivierung aus dem Spiel heraus zumeist keine Filter-"Optimierungen" angesetzt wurden, bei Aktivierung per Control Panel dafür um so mehr. Da aber inzwischen die allermeisten der heutigen Spiele eigene Optionen für den anisotropen Filter mit bringen, haben wir uns rein auf diese Variante konzentriert.

Und letztlich haben wir uns nachfolgend bei der Darstellung der herauskommenden Filterqualität wieder allein auf Direct3D und dort das Tool D3D AF-Tester [37] verlassen, da OpenGL heutzutage im Spiel-gesteuerten Modus keine Unterschiede mehr zeigt. Und damit zu den Möglichkeiten von ATIs Radeon X1x00 Serie, wobei wir hier nur den Standard-Modus sowie das zuschaltbare Area-AF berücksichtigen, den von der Bildqualität her schwächeren Modus "Advanced" sowie das in der Praxis eher nutzlose "A.I. off" ergo nicht betrachten werden:

Sehr deutlich wird erst einmal im Vergleich von 4x zu 16xAF im Standard-Modus, wie wenig Gewinn an Bildqualität man damit doch erhält – und obwohl es sich immerhin um einen Sprung von zwei Stufen handelt. Die ab 4xAF allerdings einsetzende Winkelabhängigkeit verhindert jedoch effektiv, daß man unter 8x bzw. 16xAF all zu häufig mit 8x oder 16x gefiltere Texturen zu Gesicht bekommt. Zudem hat Winkelabhängigkeit auch immer den Nachteil, daß sie je nach Spielsituation in direkt nebeneinanderliegenden unterschiedlich stark gefilterten Texturen resultieren kann, was dann deutlich den optischen Eindruck stört.

Insofern ist ATIs Entscheidung, der Radeon X1x00 Serie eine (fast) winkelunabhängige anisotrope Filterung zu spendieren, nur ausdrücklich zu begrüssen – und der Effekt ist mit obigen Screenshots auch eindrucksvoll belegt. Bei der Radeon HD 2x00 Serie hat ATI dieses Prinzip im Grundsatz beibehalten, allerdings zusätzlich noch ein wenig an der Filterqualität (in der LOD-Berechnung) geschraubt, womit insbesondere die höheren AF-Modi doch noch ein wenig besser aussehen. Wieder sehen wir uns nur den Standard-Modus an, den von der Bildqualität her schwächeren Modus "Advanced" sowie das in der Praxis eher nutzlose "A.I. off" werden nicht betrachtet:

Mit den beschriebenen Verbesserungen bei den höheren AF-Modi bei der Radeon HD 2x00 Serie wird Texturenflimmern nunmehr besser vorgebeugt als bei der Radeon X1x00 Serie, insofern hat auch diese augenscheinlich kleine Verbesserung ihre Berechtigung. Zudem gibt es das Area-AF bei der Radeon HD 2x00 Serie jetzt per default – was auch dementspricht, was nVidia bei der GeForce8-Serie anbietet.

Deutlich zurückhängend bezüglich des anisotropen Filters bleibt weiterhin die GeForce7-Serie von nVidia, hier fehlt es im Vergleich zu den anderen im Markt angebotenen Möglichkeiten inzwischen klar an einem winkelunabhängigen anisotropen Filter. Nachfolgend sei der Standard-Modus "Quality" sowie der bessere Modus "High Quality" der GeForce7-Serie aufgezeigt, die beiden von der Bildqualität her schwächeren Modi "Performance" und "High Performance" werden wir dagegen nicht betrachten:

Auf den ersten Blick wird hier schon klar, daß nVidias default-Modus bei der GeForce7-Serie nicht mit ATIs default-Modus vergleichbar ist: Während dieser bei ATI auf einen trilinearen Grundfilter (bei Anforderung des anisotropen Filters über das Spiel) inklusive einer doch schon anständig zu nennenden Gesamtqualität setzt, bekommt man bei nVidias GeForce7-Serie nur einen brilinearen Grundfilter samt mehrerer mittelschwerer bis gravierender Filter-"Optimierungen". Diese lassen sich zwar teilweise abschalten, aber dann passt natürlich die Performance wie auch die Bildqualität nicht mehr zum "Quality"-Modus, sondern es geht dann schon in Richtung des "High Quality" Modus.

Somit erscheint letztgenannter Modus auch als die einzig richtige Wahl, will man nVidias GeForce7-Grafikkarten mit der ATI-Bildqualität vergleichen – nVidias "High Quality" liegt zumindestens klar näher an ATIs Standard-Qualität als der GeForce7-default-Modus "Quality". Für ATIs zusätzlichen Modus "Area-AF" hat nVidia wie schon erwähnt innerhalb der GeForce7-Serie kein Äquivalent, hier liegt der Bildqualitäts-Vorteil dann eindeutig bei ATI.

Beim aktuellen G80-Chip hat nVidia hingegen enorm zugelegt bei der Filterqualität und bietet nun bei der höchsten verfügbaren Einstellung die beste derzeit verfügbare Filterqualität – auch inklusive weitestgehender Winkelunabhängigkeit – an. Allerdings wird die default-Einstellung "Quality" des nVidia-Treibers weiterhin mit einem brilinearen Filter "garniert", was zumindestens den GeForce 8800 HighEnd-Grafikkarten wohl nicht ganz gerecht wird:

nVidia wäre hier also allerhöchstens der kleine Vorwurf zu machen, warum man nicht gleich "High Quality" zum Standardfiltermodus zumindestens für die GeForce 8800 Serie erhoben hat. Aber dies wäre Haarspalterei – wer will, der kann mit minimalen Änderungen an den Treibereinstellungen zu einer herausragenden Filterqualität kommen, welche selbst den hohen Standard der ATI-Karten (geringfügig) zu überbieten in der Lage ist.

Somit bieten letztendlich inzwischen beide Grafikchip-Entwickler mit ihren neuesten Grafikchip-Serien (ATI Radeon HD 2x00 und nVidia GeForce8) jeweils einen anisotropen Filter, welcher unter dem strengen Blick unseres Redakteurs aths mit dem Gütesiegel "aths-approved" durchgeht. Wenn man zurückdenkt, was in der Vergangenheit so alles an Filter-"Optimierungen" durch die beiden Grafikchip-Entwickler vorgenommen wurden, ist dies schon eine sehr bemerkenswerte Entwicklung.

Praxisvergleich anisotroper Filter

Ebenso wie bei den Praxisvergleichem zum Anti-Aliasing soll nun auch noch die Bildqualität des anisotropen Filters in der Praxis gegengeprüft werden. Dazu wurde für die nachfolgenden Tests das Spiel Max Payne 2 herangezogen. Jenes ist durchaus bekannt dafür, sich sehr allergisch auf Optimierungen zu geben. Im folgenden vergleichen wir die Chips R580 und R600 von ATI mit dem G80-Chip von nVidia. Dabei nutzen wir jeweils den vom Treiber voreingestellten Qualitätsmodus sowie die maximale Qualitätsstufe, welche dem Benutzer vom Hersteller erlaubt wird, bei ATI "A.I. off" und bei nVidia "High Quality".

[52]

[52]

ATI R580 16xAF A.I. on (MouseOut) vs. 16xAF A.I. off (MouseOver) [52]

Der Unterschied zwischen aktiviertem A.I. und dem Modus ohne Optimierungen ist an sich nur sehr subtil. Überhaupt sind in der Nähe des Spielers keine Unterschiede feststellbar. Auch in der Ferne verschwinden alle Differenzen der beiden Modi. Nur im mittleren Bereich des Bildschirms zeigen sich sichtbare Abweichungen. Dies ist auch der Teil, an dem gefürchtete Konstrastbänder und Flimmern am stärksten ins Gewicht fallen, da der Spieler auf diese Stellen den Blick am häufigsten zentriert. Insgesamt wirkt das stehende Bild mit aktiviertem A.I. minimal schärfer (unteres Drittel des Bildes betrachten), erzeugt dadurch aber auch gröbere Abstufungen. In Bewegung resultiert dies in einem leichten Flimmern.

[53]

[53]

nVidia G80 16xAF "Quality" (MouseOut) vs. 16xAF "High Quality" (MouseOver) [53]

Das Bild wirkt im "Quality"-Modus inklusive der dabei per default mitlaufenden "Optimierungen" im unteren Drittel etwas schärfer, wirkt dadurch aber auch weniger homogen. Im Gegensatz zum R580-Chip sind die Unterschiede aber über einen weiten Bereich zu erkennen. Zwischen "High Quality" des G80-Chips und dem "A.I. off" des R580-Chips sind bei stehendem Bild nahezu keine Unterschiede mehr auszumachen. Erst einmal in Bewegung, setzt sich das "High Quality" des G80-Chips dann aber doch an die Spitze.

[54]

[54]

ATI R600 16xAF A.I. on (MouseOut) vs. 16xAF A.I. off (MouseOver) [54]

Der R600-Chip zeigt das schärfste Bild, wenn A.I. deaktiviert wird. Im Gegensatz zum R580 sind die Unterschiede ebenfalls über einen größeren Bildbereich erkennbar. Insgesamt wirkt das Bild gegenüber dem Vorgänger schärfer und gleichzeitig homogener. "A.I. on" beim R600-Chip ist somit mit dem "A.I. off" beim R580-Chip und "High Quality" beim G80-Chip nahezu identisch. Ein Flimmern war nicht festzustellen, wenngleich die Bildschärfe in Bewegung gegenüber dem G80-Chip zurückstecken muss. Mit deaktiviertem A.I. zeigt der R600-Chip ein noch schärferes Bild als R580 und G80 darstellen können, ohne dabei aber zu flimmern.

Testumgebung und -settings

Mit diesem Test kam ein von unseren üblichem Testsystem abweichendes PC-System zum Einsatz, welches mit einem auf 3 GHz übertakteten Core 2 Duo Prozessor dennoch genügend Leistung für die nachfolgenden Tests zur Verfügung sollte:

| Testsystem | |

|---|---|

| Prozessor | Intel Core 2 Duo E6400, Allendale-Core mit zwei Kernen (DualCore), 2133 MHz, Sockel 775, 2 MB Level2 Cache (shared), FSB1066 |

| benutzte Taktfrequenzen | für die eigentlichen Grafikkarten-Tests: 3000 MHz (8x375), FSB1500, DDR2/750 (Niveau ca. "X6800") |

| Mainboard | Asus P5B, Sockel 775, Intel P965 + ICH8 |

| Speicher | 4x 1 GB Aeneon DDR2/667, Ratings: 5-5-5-15 @ DDR2/750 |

| Soundkarte | Creative SoundBlaster Audigy4 |

| Festplatte | Samsung P120, 250 GB, SATA1 |

| Laufwerke | Phillips DVD-RW 16x |

| Netzteil | beQuiet Straight Power 600W |

| Peripherie | HP f2105 Widescreen TFT, maximale Auflösung: 1680x1050 BenQ 757 Röhrenmonitor, maximale Auflösung: 1280x1024 Logitech MX700 Maus + HP OEM Keyboard |

| Software | Microsoft Windows XP Professional, Service Pack 2 (inklusive DirectX 9.0c) |

| Grafikkarten | Club3D Radeon X1900 XT 512MB, 625/625 MHz (Catalyst 7.4, "A.I. low") Club3D Radeon HD 2900 XT 512MB, 740/825 MHz (Beta-Treiber 8.3742, "A.I. low") Club3D GeForce 8800 GTX 768MB, 575/1350/900 MHz (Forceware 158.19, "Quality") |

Zu beachten wäre hier vor allem der Umstand, daß wir die Tests der Radeon HD 2900 XT bereits mit dem erst am Freitag seitens ATI herausgegebenen neuen Beta-Treiber 8.3742 angegangen sind.

Bei der Radeon X1900 XT und der Radeon HD 2900 XT wurde bezüglich der Filtersettings generell "A.I. low" (die default-Einstellung) gewählt, zusätzlich war bei der Radeon X1900 XT das bessere, weil weitestgehend winkelunabhängige Area-AF aktiv (was bei der Radeon HD 2900 XT sowieso Standard ist). Bei der GeForce 8800 GTX wurde hingegen das Filtersetting "Quality" gewählt, weil diesen den Filterqualitäten der Vergleichskarten am nähesten kommt.

Als Testsettings wurden folgende Settings gewählt, welche die benutzten Grafikkarten sowohl nach unten (Radeon X1900 XT) als auch nach oben (GeForce 8800 GTX & Radeon HD 2900 XT) möglichst gut auslasten sollten:

- 1280x1024 (5:4), 8x Anti-Aliasing, 16x anisotroper Filter

- 1280x1024 (5:4) , 8x Anti-Aliasing + Custom Filter Anti-Aliasing (24x) bzw. Coverage Sample Anti-Aliasing (16xQ), 16x anisotroper Filter

- 1680x1050 (16:10) , 4x Anti-Aliasing, 16x anisotroper Filter

Hierbei sollte unbedingt erwähnt werden, dass bei ATI im zweiten Setting das 24xCFAA mit Edge Detection und bei nVidia das 16xQ zum Einsatz kam. Da die Radeon X1900 XT weder CFAA noch 8xMSAA beherrscht, kann sie lediglich in letztem Setting gegen die beiden Direct3D10-Boliden antreten.

Bezüglich des Sounds wurden die Creative-Soundkarte üblicherweise mit maximaler Qualität und wenn möglich auf EAX 5.1 betrieben. In den Benchmark-Spielen selber wurde ausschließlich die maximal mögliche Bildqualität gewählt:

- Anno 1701

Version: 1.01, Settings: alles auf maximum - Armed Assault

Version: 1.05, Settings: alles auf maximum - Gothic 3

Version: 1.12, alles auf maximum - Need for Speed: Carbon

Version: 1.3, Settings: alles auf maximum - Test Drive Unlimited

Version: 1.0, Settings: alles auf maximum - Stalker: Shadow of Chernobyl

Version: 1.001, Settings: alles auf maximum - The Elder Scrolls IV: Oblivion

Version: 1.5.11, Settings: alles auf maximum, mit HDR-Rendering

Zusätzlich kamen noch folgende synthetischen Benchmarks zum Einsatz:

- 3DMark06

- D3D Rightmark

- Fablemark

- Villagemark

- Shadermark 2.1 (Build 130a)

Wie mittlerweile bei uns üblich, haben wir zur Performance-Ermittlung wieder auf Savegames anstatt auf Timedemos zurückgegriffen. Dies ermöglichte uns, auch aufgrund der Kürze der Savegames, speziell nur jene Szenen herauszusuchen, welche wir auch wirklich vermessen wollten – während bei einem Timedemo meistens mehrere Szenen (und viel Leerlauf) auf einmal vermessen werden, welche aber jeweils unterschiedliche Performance-Charakteristiken aufweisen können. Ein Timedemo-Durchlauf verwischt diese unterschiedlichen Szenen und deren unterschiedliche Performance-Charakteristik aber immer zu einer einzelnen Performance-Aussage, was die Aussagekraft einer solchen Messung dann doch erheblich einschränkt.

Anstatt Messungen des eher durchschnittlichen Gameflusses mittels Timedemos stellen unsere Messungen ausgewählter kurzer Szenen über den Weg der Savegames somit eher Worstcase-Benchmarks dar: Wir messen dann, wenn die Hardware wirklich unter Stress gerät – und eben auch nur die jeweilige Szene und nicht noch jede Menge Leerlauf oder gleich eine andere Szene mit hinzu. Konkret können wir sogar behaupten, daß die für die jeweiligen Test-Spiele von uns verwendeten Szenen mit zu den stressigsten des gesamten jeweiligen Spiels gehören und demzufolge sicherlich sehr realitätsnah sind.

Dies bezieht sich jedoch rein nur auf den Singleplayer-Part der jeweiligen Spiele. Denn der Multiplayer-Modus der meisten Spiele unterscheidet sich oft gravierend in Sachen Anzahl der im Einsatz befindlichen Einheiten und darzustellender Effekte, wodurch sich die CPU- und GPU-Last deutlich vom "üblichen" Singleplayer-Gameplay unterscheiden kann. Natürlich ist bekannt, daß im Multiplayer-Modus üblicherweise zuerst die CPU deutlich mehr belastet wird, dennoch wollen wir unsere Benchmark-Ergebnisse sicherheitshalber nur auf den Singleplayer-Modus der jeweiligen Spiele bezogen wissen.

Von den benutzten Savegames wurden jeweils immer die ersten drei bis fünf Sekunden zur Messung benutzt, welche dabei immer mittels Fraps [55] durchgeführt wurden. Dabei wurde jedes Savegame mehrfach ausgeführt wie gemessen und dann der Durchschnitt dieser Messungen als Ergebnis genommen. Die einzelnen Savegames wurden im übrigen nicht bewußt nach einer Grafikkarten- oder CPU-Limitierung ausgesucht, sondern es wurde nach ausgiebigem Spielen des jeweiligen Titels diese Szenen ausgewählt, welche uns am allgemeingültigsten und Hardware-fordernsten erschienen. Aufgrund der Kürze der für diesen Artikel zur Verfügung stehenden Zeit haben wir allerdings nur zwei der ansonsten vier üblichen Savegames pro Spiel vermessen.

Skalierung AA/AF

Natürlich interessierte uns das Skalierungsverhalten der Testkandidaten unter Verwendung der bekannten wie gerade auch der neuen Anti-Aliasing Verfahren. Getestet wurde dies unter The Elder Scrolls IV: Oblivion im Savegame "Herzland" unter der Auflösung von 1680x1050, allerdings in diesem Fall ohne der Zuschaltung des anisotropen Filters:

Hier behauptet sich die Radeon HD 2900 XT erstaunlich gut gegen ihren Gegner. Ihre hohe Bandbreite kann sie hier wohl hervorragend ausspielen, womit der eigene Vorgänger auch klar besiegt wird. Interessant: Das Edge Detection Custom Filter Anti-Aliasing ist deutlich "teurer" als echtes höheres Multisampling und das Coverage Sample Anti-Aliasing von nVidia. Ob dies in kommenden Treibern noch eine Beschleunigung erhalten wird, bleibt zu abzuwarten (und zu erhoffen).

Das Skalierungsverhalten des anisotropen Filters soll ebenfalls nicht unbeachtet bleiben. Wiederum wurde hierzu The Elder Scrolls IV: Oblivion im Savegame "Herzland" unter der Auflösung von 1680x1050 herangezogen, ebenfalls wurde hierbei wiederum Anti-Aliasing nicht zugeschaltet, sondern nur die einzelnen AF-Stufen erhöht:

Klar besiegt die Radeon HD 2900 XT hier ihren Vorgänger, kann aber gegen die enorme Texturierungsleistung der GeForce 8800 GTX mit zunehmenden AF-Grad nicht mehr mithalten. Diese erledigt die gestellte Aufgabe mit erstaunlich geringen Verlusten: Zwar kann man (noch) nicht von "AF for free" sprechen, allerdings sind die Performanceverluste bei höheren AF-Graden klar bedeutungslos.

Theoretische Benchmarks

Als obligatorischer Benchmark für die Spielergemeinde dürfte sich, trotz der geringen Praxisrelevanz, der 3DMark06 eingebürgert haben. Dessen Ergebnisse wollen wir dem Leser natürlich nicht vorenthalten:

| 3DMark06 | |||

|---|---|---|---|

| Radeon X1900 XT | Radeon HD 2900 XT | GeForce 8800 GTX | |

| Gesamtscore (3DMarks) | 6192 | 11024 | 11147 |

| Game Test 1 (fps) | 18 | 36 | 42 |

| Game Test 2 (fps) | 20 | 41 | 43 |

| Game Test 3 (fps) | 26 | 47 | 46 |

| Game Test 4 (fps) | 27 | 58 | 54 |

| Single Texturing (MPixel/sec) | 4571 | 7857 | 6913 |

| Multi Texturing (MPixel/sec | 9891 | 11813 | 17823 |

| Vertex Shader (MVert/sec) | 175 | 310 | 229 |

| Vertex Shader compl. (MVert/sec) | 59 | 191 | 107 |

Im 3DMark 2006 liegen die bei beiden Direct3D10-Boliden doch ziemlich ähnlich. Im Vertexshader-Test gibt es jedoch eine erste Aussage: Der R600-Chip schneidet hier wesentlich besser ab, während die Radeon X1900 XT hierbei bereits deutlich zurückfällt. Interessant zudem, wie die Radeon HD 2900 XT im SingleTexturing-Test problemlos mit der GeForce 8800 GTX mithalten kann, im MultiTexturing-Test jedoch deutlich zurückfällt.

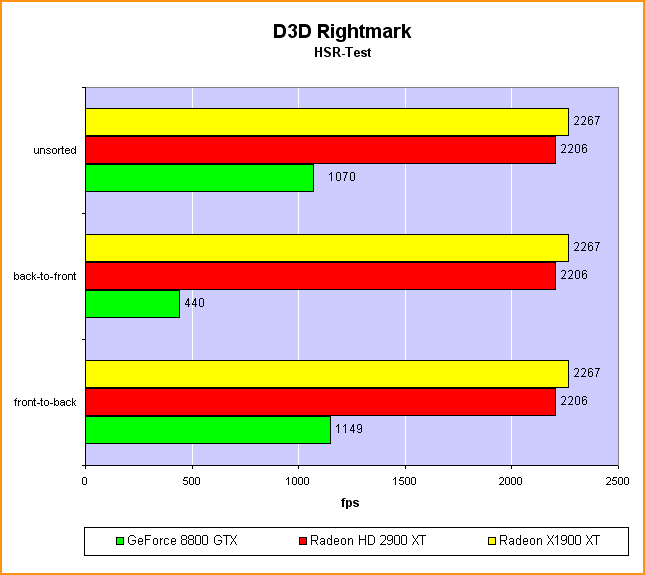

Der synthetische Benchmark "D3D Rightmark" bietet die Möglichkeit, einzelne Flaschenhälse von Grafikkarten zu testen:

Traditionell liegen die Radeon-Karten in Hidden Surface Removal Benchmarks aufgrund ihres hierarischen Z-Puffers immer vorn – so auch hier.

Die Radeon HD 2900 XT scheint im Pixelshader-Test des D3D Rightmark kaum schneller als ihr Vorgänger zu sein. Hier scheint angesichts der (auf dem Papier) doch deutlich leistungsfähigeren R600-Architektur noch einiger Spielraum für Verbesserungen des Schedulers im Treiber vorhanden zu sein. Die GeForce 8800 GTX liegt dagegen in diesem Test deutlich vorn. Inwiefern die von diesem Test benutzten Shader stark von der Texturierungsleistung abhängig sind, ist ohne Kenntnis des Quellcodes nur schwer zu sagen. Anhand der gemessenen Ergebnisse liegt diese Vermutung allerdings nahe, weil bei der Texturierungsleistung der G80-Chip wie bekannt klar die besseren Karten hat.

Theoretische Benchmarks (Forts.)

Der Fablemark ist eine von PowerVR entwickelte Techdemo, welche die damalige Stärke der TBDR-Architektur aufzeigen sollte: Die Stencilleistung. In diesem Test limitiert diese maßgeblich, was erste Indizien auf die ROP-Leistung der verschiedenen Architekturen geben kann:

Die GeForce 8800 GTX zeigt dank ihrer 192 Z/Stencil Einheiten ihre Stärke auf diesem Gebiet. Seltsamerweise besiegt die Radeon X1900 XT ihren Nachfolger unter der Nutzung von Anti-Aliasing recht deutlich. Die Ursache hierfür könnten allerdings die noch sehr jungen Treiber der Radeon HD 2900 XT sein.

Auch der Villagemark ist eine Techdemo von PowerVR. Diese ist absolut limitiert auf die Texturfüllrate und die HSR-Leistung:

Die GeForce 8800 GTX spielt hier ihre Füllrate aus. So verliert sie auch kaum an Frames, sofern man die Filterqualität erhöht. Die Radeon-Karten verlieren bei der Erhöhung der Filterqualität hingegen einen nicht ganz unerheblichen Teil ihrer Frameraten.

Der von Tommti-Systems [56] programmierte Benchmark "Shadermark 2.01" ist ein synthetischer Benchmark zur Messung der Pixelshaderleistung.

Trotz eines noch sehr jungen Treibers zeigt die Radeon HD 2900 XT in diesem Test bereits sehr ansprechende Ergebnisse bezüglich ihrer Shaderleistung.

Benchmarks Anno 1701

Der erste in diesem Test betrachtete Spielebenchmark bildet Anno 1701. Hierbei kamen die recht CPU-lastigen Savegames "Seeschlacht" und "Landgefecht" zum Einsatz:

Mit leichten Vorteilen gewinnt die GeForce 8800 GTX im Savegame "Seeschlacht" das Rennen, während die Radeon HD 2900 XT überall zurückhängt. Dies ist besonders deutlich, wenn man CFAA/CSAA zuschaltet, hier liegt nVidia dann schon erheblich vorn. Im einzigen Test mit der Radeon X1900 XT besiegt diese zudem erstaunlicherweise ihren Nachfolger – möglicherweise ist der Treiber für die Radeon HD 2900 XT noch nicht so CPU-schonend wie der (ausgereifte) für die Radeon X1900 XT.

Die Radeon HD 2900 XT liegt in diesem Savegame dagegen vorn, kann sich jedoch kaum von ihrem Vorgänger absetzen. Die Unterschiede sind in diesem Savegame jedoch allgemein gering, wahrscheinlich zurückzuführen auf die hier anliegende hohe CPU-Last.

Benchmarks Armed Assault

In diesem Benchmark wurde das Verhalten der Grafikkarten im Spiel Armed Assault mit den Savegames "Geprügelter Hund" und "Gegenangriff" getestet:

In diesem Savegame liegt die GeForce 8800 GTX überall und teilweise erheblich vorn. Auch hier kann sich die Radeon HD 2900 XT nicht wirklich von ihrem Vorgänger in der Form der Radeon X1900 XT absetzen. Unter CFAA/CSAA erreicht die Radeon HD 2900 XT jedoch zumindest im Prinzip dasselbe Ergebnis wie die GeForce 8800 GTX.

Hier zeigt sich ein relativ gleichwertiges Ergebnisspektrum, was eine starke CPU-Limitierung in diesem Savegame vermuten läßt.

Benchmarks Gothic 3

Dieses Spiel unterstützt keine Verwendung von Anti-Aliasing und wird somit nur mit einem 16x anisotropen Filter in den Savegames "1. Tag" und "34. Tag" getestet:

Die GeForce 8800 GTX liegt in diesem Savegame sehr weit vorn. Die Vielzahl an texturierten Gräsern und Blättern kosten richtig Texturleistung, welche bei der GeForce 8800 GTX klar am größten ist. Die Radeon HD 2900 XT kann sich zwar deutlich von ihrem Vorgänger absetzen, liegt dafür aber auch weit hinter der GeForce 8800 GTX zurück.

Etwas seltsam sind diese Benchmarks, da der nicht vorhandene Unterschied zwischen den beiden ATI-Grafikkarten eher für eine CPU-Limitierung spricht, der große Vorsprung der GeForce 8800 GTX vor den beiden ATI-Grafikkarten jedoch anderes vermuten läßt. Möglicherweise liegt es auch schlicht nur am Treiber für die Radeon HD 2900 XT, welche diese Karte in diesem Savegame stärker limitiert, als was die Karte aufgrund ihrer Rohleistung eigentlich bieten könnte.

Benchmarks Need for Speed: Carbon

In diesem Benchmark testen wir nur das Savegame "Start erstes Rennen":

Die Radeon HD 2900 XT deklassiert hierbei ihren Vorgänger und kommt unter 1680x1050 unter Nutzung von 4x Anti-Aliasing sogar an das Ergebnis der GeForce 8800 GTX heran. In der kleineren Auflösung 1280x1024 und den dort eingesetzten Anti-Aliasing Modi 8xMS und 8xMS mit CFAA/CSAA muß sie sich der nVidia-Karte jedoch klar geschlagen geben.

Benchmarks Test Drive Unlimited

Auch hier kommt mit "Aus der Garage" nur ein Savegame zum Einsatz:

Völlig abweichend zum bisherigen Testfeld sind diese Benchmarks, welche die Radeon HD 2900 XT klar vorn sehen. Dabei ist in diesem Spiel noch nicht einmal eine deutliche ATI-Präferenz zu entnehmen, denn die GeForce 8800 GTX liegt immer noch klar vor der Radeon X1900 XT. Die Radeon HD 2900 XT überflügelt die nVidia-Karte in diesem Benchmark jedoch trotzdem deutlich.

Benchmarks Stalker: Shadow of Chernobyl

In diesem kürzlich erschienenen Spiel haben wir auf die beiden Savegames "Startszene" und "Letztes Gefecht" zurückgegriffen. Allerdings unterstützt Stalker: Shadow of Chernobyl wegen des Einsatzes von Deferred Shading kein Anti-Aliasing – das diesbezüglich im Spiel zu findende Setting aktiviert nur einen Blurfilter, welcher natürlich für unsere Messungen nicht zum Einsatz kam:

Die Startszene des Spiels meistert wieder einmal die GeForce 8800 GTX mit Abstand am besten. Auffallend ist zudem der doch recht geringe Performanceunterschied zwischen den beiden ATI-Karten, welcher kaum dem (vorhandenen) Unterschied an Rohleistung entspricht.

Ein sehr ähnliches Bild ergibt sich dann auch unter diesem Savegame: Wieder liegt die GeForce 8800 GTX nahezu spielend vorn, wieder gibt es kaum einen relevanten Unterschied zwischen "alter" Radeon X1900 XT und neuer Radeon HD 2900 XT.

Benchmarks The Elder Scrolls IV: Oblivion

Neben Gothic 3 ist The Elder Scrolls IV: Oblivion das beliebteste und ressourcenfressenste Spiel des Jahres 2006 gewesen. Wir testen in den beiden Savegames "Herzland" und "Goldküste":

Dieses Savegame scheint größtenteils Grafikkarten-limitiert zu sein. Die Radeon HD 2900 XT schlägt ihren Vorgänger hier deutlich, muss sich jedoch ihrem eigentlichen Kontrahenten von nVidia ebenso eindeutig geschlagen geben. Die hohen Texelfüllraten-Bedürfnisse für Gräser und Bäume zusätzlich zum anisotropen Filter dürften für diesen deutlichen Unterschied maßgeblich verantwortlich sein.

Direkt vor einem Tor zur Hölle können schonmal die Frames einbrechen: Die Radeon HD 2900 XT geht in diesem Savegame erstaunlicherweise als klarer Sieger hervor, sogar ihr Vorgänger schlägt die GeForce 8800 GTX. Sicherlich kann man angesichts der Werte der GeForce 8800 GTX vermuten, daß hierbei ein Treiberbug seitens nVidia vorliegt.

Fazit

Prinzipiell sind die vorherigen Benchmarks ziemlich eindeutig: Gegenüber der schon seit einem halben Jahr im Markt befindlichen GeForce 8800 GTX hat die neue ATI-Topkarte keine wirkliche Chance, verliert die große Mehrzahl der Benchmarks mit zumeist recht klarem Abstand. Nachfolgende Tabelle gibt hierzu noch einmal einen Überblick über die erzielten Einzelresultate:

| Leistungsdifferenz der Radeon HD 2900 XT zur GeForce 8800 GTX | |||

|---|---|---|---|

| 1280x1024, 8xAA, 16xAF | 1280x1024, 4xAA + CFAA (24x)/CSAA (16xQ) | 1680x1050, 4xAA, 16xAF | |

| Anno 1701 | Performance: ausgeglichen Spielbarkeit: ATI vernünftig, nVidia grenzwertig |

Performance: klarer Vorteil nVidia Spielbarkeit: beide grenzwertig |

Performance: geringer Vorteil ATI Spielbarkeit: ATI vernünftig, nVidia grenzwertig |

| Armed Assault | Performance: klarer Vorteil nVidia Spielbarkeit: beide problemlos |

Performance: ausgeglichen Spielbarkeit: beide vernünftig |

Performance: geringer Vorteil nVidia Spielbarkeit: beide vernünftig |

| Gothic 3 (kein AA) | Performance: dramatischer Vorteil nVidia Spielbarkeit: beide problemlos |

- | Performance: dramatischer Vorteil nVidia Spielbarkeit: ATI vernünftig, nVidia problemlos |

| Need for Speed: Carbon | Performance: klarer Vorteil nVidia Spielbarkeit: beide problemlos |

Performance: dramatischer Vorteil nVidia Spielbarkeit: ATI vernünftig, nVidia problemlos |

Performance: ausgeglichen Spielbarkeit: beide problemlos |

| Test Drive Unlimited | Performance: dramtischer Vorteil ATI Spielbarkeit: beide problemlos |

Performance: klarer Vorteil ATI Spielbarkeit: beide problemlos |

Performance: klarer Vorteil ATI Spielbarkeit: beide problemlos |

| Stalker: Shadow of Chernobyl (kein AA) | Performance: klarer Vorteil nVidia Spielbarkeit: ATI vernünftig, nVidia problemlos |

- | Performance: dramtischer Vorteil nVidia Spielbarkeit: ATI grenzwertig, nVidia vernünftig |

| The Elder Scrolls IV: Oblivion | Performance: ausgeglichen Spielbarkeit: ATI vernünftig, nVidia ungenügend |

Performance: ausgeglichen Spielbarkeit: ATI grenzwertig, nVidia ungenügend |

Performance: ausgeglichen Spielbarkeit: ATI grenzwertig, nVidia ungenügend |

| The Elder Scrolls IV: Oblivion (wenn man das Savegame "Goldküste" als Treiberbug nicht zählt) | Performance: klarer Vorteil nVidia Spielbarkeit: beide problemlos |

Performance: dramatischer Vorteil nVidia Spielbarkeit: beide problemlos |

Performance: klarer Vorteil nVidia Spielbarkeit: beide problemlos |

Dieser Aufstellung ist gut zu entnehmen, wie oft die nVidia-Karte klar oder dramatisch vorn liegt bei der reinen Performance. Gleichfalls kann man aber auch sehen, daß dies nicht in jedem Fall einen konkreten Unterschied in der Spielbarkeit des jeweiligen Spiels ergibt – schneller als ausreichend schnell muß es schließlich dafür nicht sein. Allerdings kauft man sich eine HighEnd-Grafikkarte natürlich auch wieder nicht nur, um mit den aktuellen Spielen alles flüssig zu haben, sondern auch, um noch Reserven für mindestens die nähere Zukunft zu haben.

Der wohl entscheidenste Punkt wider einer direkten Bewertung von GeForce 8800 GTX gegen Radeon HD 2900 XT ist allerdings der Preis: Während die nVidia-Karte derzeit für knapp unter 500 Euro zu haben ist, geht die neue ATI-Karte mit einem Listenpreis von 399 Dollar in den Handel und soll sich innerhalb kürzester Zeit nach dem Auftauchen der ersten Angebote auf 350 Euro einpegeln. ATI hat hier also bewußt keine Karte aufgelegt, welches es mit der GeForce 8800 GTX aufnehmen können soll – dies schafft sie von der Leistung her erwiesenermaßen nicht und hat daher eben auch einen völlig anderen Preispunkt.

Sicherlich eher geeignet als Radeon HD 2900 XT Konkurrent ist somit die GeForce 8800 GTS 640MB, welche in ähnlichen Preis- und Leistungsregionen liegt. Für diesen Artikel hatten wir eine solche Karte leider nicht zur Verfügung, aber sicherlich wird sich zukünftig die Gelegenheit ergeben, Radeon HD 2900 XT und GeForce 8800 GTS 640MB an dieser Stelle in einem Artikel gegenüberzustellen. Vor den heutigen Leistungsmessungen ausgehend dürfte sich dabei normalerweise die ATI-Karte durchsetzen, da die GeForce 8800 GTS 640MB bekanntermaßen um die 30 bis 40 Prozent hinter der GeForce 8800 GTX zurückhängt, der Rückstand der Radeon HD 2900 XT zu dieser aber doch geringer ausfällt.

Allerdings fallen die Preise für GeForce 8800 GTS 640MB Karten derzeitig rasant, verschiedene Exemplare werden (nicht lieferbar) schon für unter 300 Euro angeboten, lieferbare Karten sind immerhin schon für 310 Euro zu haben. Insofern wird die GeForce 8800 GTS 640MB trotz zu prognostizierender geringerer Performance gegenüber der Radeon HD 2900 XT immer ein harter Gegner für diese sein, da einfach der Preispunkt jetzt schon besser ist als bei der neuen ATI-Karte. Zwar gibt es Stimmen, die davon berichten, daß auch die Radeon HD 2900 XT schnell auf Preise von 320 bis 330 Euro herabsinken wird – ganz ehrlich wollen wir eine solche Entwicklung aber erst einmal abwarten, ehe sich Spekulationen darüber erlauben.

In der Summe hat ATI mit der Radeon HD 2900 XT auf Basis des R600-Chips also eine Grafikkarte vorgestellt, welche für das untere HighEnd-Segment vorgesehen ist, zweifelsfrei nicht als wirklichen Angriff auf die Modelle des oberen HighEnd-Segments in Form von GeForce 8800 GTX und Ultra. Diesen vor allem durch den Preis zum Ausdruck gebrachten Anspruch kann die neue ATI-Karte sicherlich erfüllen und bietet im Rahmen dessen auch ein absolut vernünftiges Preis/Leistungsverhältnis. Zu einem wirklich herausragenden Preis/Leistungsverhältnis reicht es jedoch nicht, weil man diesbezüglich letztlich nicht besser als nVidia mit der GeForce 8800 GTS liegt.

Allerdings muß auch klar gesagt werden, daß das große Bild nicht wirklich berauschend ist: Zum einen trat der R600-Chip einstmals doch an, um nVidia (erneut) das Fürchten zu lehren. Davon ist derzeit nicht viel zu sehen, selbst wenn ATI diesbezüglich in jüngerer Vergangenheit schon wieder zurückgerudert hatte. Aber von einem so lange immer wieder verschobenen Projekt hätte man einfach mehr erwarten können. Daß es jetzt sogar nur noch zu einer Präsentation mit offensichtlich nicht ausgereiften Treibern gereicht hat, ist das andere Ärgerniss: Die Rohleistung des Grafikchips wird offensichtlich noch nicht vollständig auf die Schiene gebracht, zudem doktorte man noch am Transparenz Anti-Aliasing herum. Gerade bei den vielen Launchverschiebungen der Vergangenheit hätte doch eigentlich Zeit sein müssen, um diese Problematik gleich vom Start weg im Griff zu haben.

Insofern liegt trotz der langen Verzögerung noch einiges an intensiver Treiberarbeit von ATI, um die Radeon HD 2900 XT dort hin zu bekommen, wo sie hin soll. Sicherlich kann man diesbezüglich die Vermutung anstellen, daß ATI hier in den nächsten Wochen noch 10 bis 20 Prozent Performance herauskitzeln wird können – wobei ATI uns dieses natürlich beweisen muß, für die Vermutung kann sich keiner etwas kaufen. Zudem wären eigene R600-Boardlayouts der Grafikkartenhersteller zu begrüßen, welche mit anderer Kühler/Lüfterkonstruktion die doch zu hohe Lautstärke der Karte im 3D-Betrieb lindern helfen könnten.

Zum Ende dieses Artikels möchte ich mich bei meinem Kollegen und Freund Max Meier bedanken. Ohne seine Auswertung zu den Oblivion-Screenshots wäre der Bildqualitäts-Teil nicht rechtzeitig fertig geworden. Weiterhin danke ich aths und Xmas für ihre Beratung in technischen Aspekten. Auch Lars Weinand und Eric Demers von ATI/AMD seien für die exzellente Unterstützung hinsichtlich der R600-Informationen gedankt. Ohne diese Leute wäre der Artikel in dieser Form nicht möglich gewesen.

Links zu weiteren Tests

Wie üblich geben wir an dieser Stelle noch einen Querschnitt weiterer Tests zum R600-Chip bzw. zur Radeon HD 2900 XT Grafikkarte zum besten, um das Thema vertiefen oder aber sich weitere Meinungen einholen zu können:

- ATI Radeon HD 2900 XT: Ein neuer Platzhirsch ist geboren? (d) [57] [ComputerBase]

- ATI Radeon HD2900 XT (d) [58] [Hardwareluxx]

- ATI Radeon HD 2900 XT (d) [59] [Hartware]

- ATIs neue Grafikkartengeneration für DirectX 10 (d) [60] [PC-Welt]

- Neuer ATI Radeon HD 2900 XT mit Performance-Problemen (d) [61] [tecChannel]

- AMD Radeon HD 2900 XT: Später Angriff (d) [62] [Technic3D]

- ATI Radeon HD 2900 XT: Motor startet, was passiert? (d) [63] [Tom's Hardware Guide]

- AMD R600 Architecture and GPU Analysis (e) [64] [Beyond3D]

- HD2000 – The First GPU's Under the AMD Name (e) [65] [Bjorn3D]

- Asus & Sapphire Radeon HD 2900XT (e) [66] [DriverHeaven]

- Radeon HD 2000 Series: 3D Architecture Explained (e) [67] [ExtremeTech]

- AMD-ATI Radeon HD 2900 XT Performance Preview (e) [68] [FiringSquad]

- ATI Radeon HD 2900 XT 512MB Review (e) [69] [Guru3D]

- ATI Radeon HD 2900 XT (e) [70] [HardOCP]

- ATI Radeon HD 2900 XTX Review (e) [71] [Hardware Secrets]

- AMD (HIS) Radeon HD 2900 XT (e) [72] [Hexus]

- ATI Radeon HD 2900 XT – R600 Has Arrived (e) [73] [Hot Hardware]

- Asus EAH2900XT 512M ATI Radeon HD 2900XT Review (e) [74] [Overclockers Workbench]

- Radeon HD 2900 XT (e) [75] [t-break]

- ATI Radeon HD 2900 XT (e) [76] [techPowerUp!]

- AMD's R600 has something of the flawed diamond about it (e) [77] [The Inquirer]

- AMD's Radeon HD 2900 XT graphics processor – R600 revealed (e) [78] [The Tech Report]

- ATI Radeon HD 2900 XT – AMD's long awaited R600 DX10 GPU arrives (e) [79] [TweakTown]

- ATI Radeon 2000 Series Launch: X2900XT Review (e) [80] [VR-Zone]

- AMD Radeon HD 2900 XT: la carte DirectX10 ultime? (franz.) [81] [PresencePC]

- AMD Radeon HD 2900 XT: DirectX 10 par ATI! (franz.) [82] [Clubic]

- ATI Radeon HD2900XT (span.) [83] [ChileHardWare]

Verweise:

[1] http://www.3dcenter.org/users/blackbirdsr

[2] http://www.3dcenter.org/users/robbitop

[3] http://www.3dcenter.org/abbildung/radeonhd2900xt

[4] http://ati.amd.com/de/

[5] http://www.bequiet.de/

[6] http://www.club3d.nl/index.php/setlang/index/deutsch

[7] http://www.pcspezialist.de/stores/Bundesland8/Partner2321/index.php

[8] http://www.forum-3dcenter.org/vbulletin/showthread.php?t=362364

[9] http://www.3dcenter.org/downloads/fsaa-tester.php

[10] http://www.3dcenter.org/dateien/abbildungen/aa_R580_filterqualitaet_0x.png

[11] http://www.3dcenter.org/dateien/abbildungen/aa_R580_filterqualitaet_2x.png

[12] http://www.3dcenter.org/dateien/abbildungen/aa_R580_filterqualitaet_4x.png

[13] http://www.3dcenter.org/dateien/abbildungen/aa_R580_filterqualitaet_6x.png

[14] http://www.3dcenter.org/dateien/abbildungen/aa_R600_filterqualitaet_0x.png

[15] http://www.3dcenter.org/dateien/abbildungen/aa_R600_filterqualitaet_2x.png

[16] http://www.3dcenter.org/dateien/abbildungen/aa_R600_filterqualitaet_4x.png

[17] http://www.3dcenter.org/dateien/abbildungen/aa_R600_filterqualitaet_8x.png

[18] http://www.3dcenter.org/dateien/abbildungen/aa_R600_filterqualitaet_24x.png

[19] http://www.3dcenter.org/dateien/abbildungen/aa_G71_filterqualitaet_0x.png

[20] http://www.3dcenter.org/dateien/abbildungen/aa_G71_filterqualitaet_2x.png

[21] http://www.3dcenter.org/dateien/abbildungen/aa_G71_filterqualitaet_4x.png

[22] http://www.3dcenter.org/dateien/abbildungen/aa_G71_filterqualitaet_8xS.png

[23] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_0x.png

[24] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_2x.png

[25] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_4x.png

[26] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_8x.png

[27] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_8xQ.png

[28] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_16x.png

[29] http://www.3dcenter.org/dateien/abbildungen/aa_G80_filterqualitaet_16xQ.png

[30] http://www.3dcenter.org/abbildung/oblivion4xaacf

[31] http://www.3dcenter.org/abbildung/oblivion4xaacs

[32] http://www.3dcenter.org/abbildung/oblivion8xaacf

[33] http://www.3dcenter.org/abbildung/oblivion8xaacs

[34] http://www.3dcenter.org/abbildung/oblivion4xtmsaacs

[35] http://www.3dcenter.org/abbildung/oblivion4xtssaacs

[36] http://www.3dcenter.org/abbildung/oblivion4xeatmcf

[37] http://www.3dcenter.org/downloads/d3d-af-tester.php

[38] http://www.3dcenter.org/dateien/abbildungen/af_R580_filterqualitaet_standard_4x.png

[39] http://www.3dcenter.org/dateien/abbildungen/af_R580_filterqualitaet_standard_16x.png

[40] http://www.3dcenter.org/dateien/abbildungen/af_R580_filterqualitaet_area_4x.png

[41] http://www.3dcenter.org/dateien/abbildungen/af_R580_filterqualitaet_area_16x.png

[42] http://www.3dcenter.org/dateien/abbildungen/af_R600_filterqualitaet_area_4x.png

[43] http://www.3dcenter.org/dateien/abbildungen/af_R600_filterqualitaet_area_16x.png

[44] http://www.3dcenter.org/dateien/abbildungen/af_G71_filterqualitaet_quality_4x.png

[45] http://www.3dcenter.org/dateien/abbildungen/af_G71_filterqualitaet_quality_16x.png

[46] http://www.3dcenter.org/dateien/abbildungen/af_G71_filterqualitaet_hq_4x.png

[47] http://www.3dcenter.org/dateien/abbildungen/af_G71_filterqualitaet_hq_16x.png

[48] http://www.3dcenter.org/dateien/abbildungen/af_G80_filterqualitaet_quality_4x.png

[49] http://www.3dcenter.org/dateien/abbildungen/af_G80_filterqualitaet_quality_16x.png

[50] http://www.3dcenter.org/dateien/abbildungen/af_G80_filterqualitaet_hq_4x.png

[51] http://www.3dcenter.org/dateien/abbildungen/af_G80_filterqualitaet_hq_16x.png

[52] http://www.3dcenter.org/abbildung/r580maxpayne16xaion

[53] http://www.3dcenter.org/abbildung/g80maxpayne16xqopt

[54] http://www.3dcenter.org/abbildung/r600maxpayne16xaion

[55] http://www.3dcenter.org/downloads/fraps.php

[56] http://www.tommti-systems.com/

[57] http://www.computerbase.de/artikel/hardware/grafikkarten/2007/test_ati_radeon_hd_2900_xt

[58] http://www.hardwareluxx.de/cms/artikel.php?action=show&id=546

[59] http://www.hartware.de/review_707.html

[60] http://www.pcwelt.de/tests/hardware-tests/pci-express-grafikkarten/80120/index.html

[61] http://www.tecchannel.de/technologie/komponenten/470343

[62] http://www.technic3d.com/?site=article&action=article&a=493

[63] http://hardware.thgweb.de/2007/05/14/ati-radeon-hd-2900-xt-r600-directx10/

[64] http://www.beyond3d.com/content/reviews/16/1

[65] http://www.bjorn3d.com/read.php?cID=1099&pageID=3433

[66] http://www.driverheaven.net/reviews/r600reviewz/video.php

[67] http://www.extremetech.com/article2/0,1697,2128920,00.asp

[68] http://www.firingsquad.com/hardware/amd_ati_radeon_hd_2900_xt_performance_preview/

[69] http://www.guru3d.com/article/Videocards/431/

[70] http://enthusiast.hardocp.com/article.html?art=MTM0MSwxLCxoZW50aHVzaWFzdA==

[71] http://www.hardwaresecrets.com/article/449

[72] http://www.hexus.net/content/item.php?item=8687&page=1

[73] http://www.hothardware.com/Articles/ATI%5FRadeon%5FHD%5F2900%5FXT%5F%5FR600%5FHas%5FArrived/

[74] http://www.ocworkbench.com/2007/asus/EAH2900XT/g1.htm

[75] http://www.tbreak.com/reviews/article.php?id=511

[76] http://www.techpowerup.com/reviews/ATI/HD_2900_XT

[77] http://www.the-inquirer.com/default.aspx?article=39580

[78] http://www.techreport.com/reviews/2007q2/radeon-hd-2900xt/index.x?pg=1

[79] http://www.tweaktown.com/articles/1100/ati_radeon_hd_2900_xt_amd_s_long_awaited_r600_dx10_gpu_arrives/index.html

[80] http://vr-zone.com/?i=4946&s=1

[81] http://www.presence-pc.com/tests/AMD-Radeon-2900-XT-22674/23/

[82] http://www.clubic.com/article-73608-1-amd-ati-radeon-hd-2900-xt-directx-10.html

[83] http://www.chilehardware.com/Revisiones/Tarjetas-de-Video/ATI-Radeon-HD2900XT-200705131808.html