Performancereport Command & Conquer: Tiberium Wars

Nachdem sich bereits Spiele wie Gothic 3 [3], Anno 1701 [4], Need for Speed: Carbon [5], Test Drive Unlimited [6], Armed Assault [7] und Supreme Commander [8] über ihre Qualitäten, Mainstream-Hardware zu quälen, outen mussten, darf nunmehr im aktuellen Spiele-Performancereport das jüngste Spiel im C&C-Universion, Command & Conquer 3: Tiberium Wars, seine diesbezüglichen Qualitäten zeigen.

Im selben Genre wie das erst kürzlich getestete Supreme Commander [9] gelegen, zeigt sich der offiziell dritte Teil der C&C-Reihe (nicht gerechnet die vielen AddOns und anderen Ableger) spielerisch allerdings vollkommen andern als das vorgenannte Spiel: Während Supreme Commander deutlich strategie-lastiger ist, stellt Command & Conquer 3: Tiberium Wars vergleichsweise eher ein "Arcade-RTS" dar. Was natürlich nichts schlechtes bedeuten muß, schließlich hat jeder einen anderen Geschmack bezüglich des Schwierigkeitsgrades und der Strategie-Lastigkeit von solcherart Spielen. Genaueres zum Spiel selber ist unter anderem den Reviews bei GameCaptain [10], GameZone [11], GBase [12] und Orthy [13] zu entnehmen.

Wir werden uns an dieser Stelle natürlich ausschließlich mit der Performance des Spiels beschäftigen. Dabei soll das Ziel der heutigen Messungen nicht unbedingt sein, konkrete Sieger zwischen den jeweiligen Rivalen auf CPU- und GPU-Seite zu ermitteln. Vielmehr geht es eher darum, generelle Tendenzen zu erkennen, mit welcher Hardware das Spiel anständig spielbar ist. Wenn sich dabei auch ein Hinweis ergibt, ob das Spiel eine bestimmte Hardware klar bevorzugt, ist das natürlich in Ordnung – aber sicherlich soll mit diesem Artikel nicht herausgefunden werden, ob die eine von uns eingesetzte CPU oder Grafikkarte die andere um drei Prozent o.ä. "schlägt".

Vorab sei an dieser Stelle den Firmen Intel [14], nVidia [15] und Sapphire [16] für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel ermöglicht wurde.

Zudem noch vielen Dank an Tony Gradius, der uns ein paar Savegames für Command & Conquer 3: Tiberium Wars zur Verfügung stellte.

Natürlich basiert auch dieser Artikel wieder auf Messungen mit Savegames anstatt Timedemos. Dies ermöglichte uns, auch aufgrund der Kürze der Savegames, speziell nur jene Szenen herauszusuchen, welche wir auch wirklich vermessen wollten – während bei einem Timedemo meistens mehrere Szenen (und viel Leerlauf) auf einmal vermessen werden, welche aber jeweils unterschiedliche Performance-Charakteristiken aufweisen können. Ein Timedemo-Durchlauf verwischt diese unterschiedlichen Szenen und deren unterschiedliche Performance-Charakteristik aber immer zu einer einzelnen Performance-Aussage, was die Aussagekraft einer solchen Messung dann doch erheblich einschränkt.

Anstatt Messungen des eher durchschnittlichen Gameflusses mittels Timedemos stellen unsere Messungen ausgewählter kurzer Szenen über den Weg der Savegames somit eher Worstcase-Benchmarks dar: Wir messen dann, wenn die Hardware wirklich unter Stress gerät – und eben auch nur die jeweilige Stress-Szene und nicht noch jede Menge Leerlauf oder gleich eine andere Szene mit hinzu. Die von uns benutzten Savegames stellen dann verschiedene Anorderungsvarianten dar – von geringen Anforderungen bis zu extrem fordernden.

Bei allen Savegames wurden jeweils immer die ersten fünf Sekunden zur Messung benutzt, welche dabei immer mittels Fraps [17] durchgeführt wurden. Dabei wurde jedes Savegame generell fünfach ausgeführt wie gemessen und dann der Durchschnitt dieser Messungen als Ergebnis genommen. Folgende Savegames kamen dabei für Command & Conquer: Tiberium Wars (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

[18] [18]Savegame "Basis mit Einheiten" [18] |

[19] [19]Savegame "Leichte Schlacht" [19] |

[20] [20]Savegame "Schwere Schlacht" [20] |

[21] [21]Savegame "Extreme Schlacht" [21] |

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur absolut grob nennen, da es bereits hier [22] umfassend ausgeführt wurde. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6400 durchgeführt, als Grafikkarten kamen dabei Radeon X1900 XT (auf Catalyst 7.2, A.I. default mit Area-AF) und GeForce 7950 GT (auf ForceWare 93.71, "High Quality") zum Einsatz. Für die CPU-Tests wurde zudem noch ein Athlon 64 X2 4600+ auf verschiedenen Taktungen herangezogen. Generell standen beiden Testsystemen jeweils zwei GigaByte Speicher zur Verfügung.

Das Spiel selber wurde in der Spielversion 1.03 und zusätzlich in einem extra Test in der Spielversion 1.04 ausgemessen. Zudem sei vorab absolut klargestellt, daß wir im Spiel selber immer die bestmögliche Grafikqualität und 5.1 Surround-Sound ausgewählt haben und sich dieser Artikel auch hauptsächlich nur auf diese bestmöglichen Settings bezieht. Senkt man die Spiel-eigenen Grafiksettings hingegen ab, kann man natürlich auch mit kleinerer Hardware als hier angegeben auskommen. Für diesen Zweck haben wir zusätzlich auch extra Tests mit mittleren und niedrigen Details durchgeführt.

Und letztlich zum besseren Verständnis der CPU-Balken: Die weiß und schwarz umrandeten Messungen stellen bewusst CPU-limitiert angesetzte Messungen mit einem Athlon 64 X2 3800+ (weiß) und einem Core 2 Duo E6400 (schwarz) dar. Diese Messungen ergeben somit, welche Performance unter Ausschaltung des Effekts der Grafikkarten erreicht wird, was uns wiederum im Quervergleich mit den Grafikkarten-Messungen die Möglichkeit an die Hand gibt, mögliche CPU-Limitierungen mit schwächeren CPUs als dem bei den Grafikkartentests eingesetzten auf 3.2 GHz übertaketeten Core 2 Duo zu erkennen. Die fps-Skala aller Diagramme geht übrigens immer so weit, wie der fps-Wert, den der Core 2 Duo @ 3200 MHz auf 640x480 erreichen konnte.

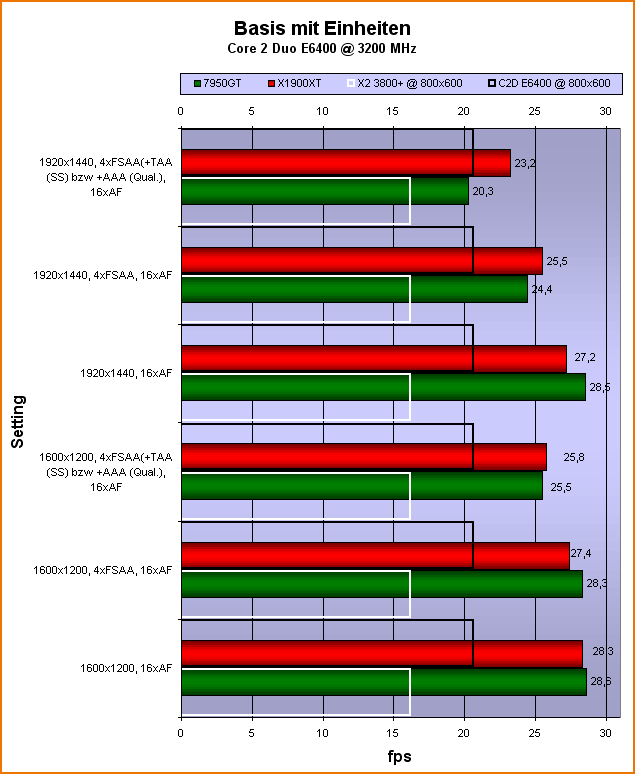

"Basis mit Einheiten"

Als erstes haben wir dann die Messungen zum ersten Savegame [23], welches schlicht eine Basis mit ein paar Einheiten und damit in dem Sinne die einfachst mögliche Anforderung darstellt:

Hier sind erst einmal keine wirklich großartigen Unterschiede zu bemerken. Allenfalls unter den beiden höchsten Bildqualitätssettings scheint die Radeon X1900 XT sich etwas besser behaupten zu können als die GeForce 7950 GT. Sehr beachtenswert sind zudem jedoch die CPU-Limits von Athlon 64 X2 3800+ (weißer Balken) und Core 2 Duo E6400 (schwarzer Balken): Diese beiden Prozessoren würden die benutzten Grafikkarten überall heftigst limitieren – was insbesondere deswegen erstaunt, weil ja schließlich in diesem Savegame noch gar nicht so viel los ist.

Savegame Benchmarks

Weiter geht es mit dem zweiten Savegame [19], welches eine leichte Schlacht zeigt:

Hierbei zeigt sich ein zum ersten Savegame verblüffend ähnliches Bild: Beide Grafikkarten liegen zumeist recht ähnlich, nur in den beiden höchsten Bildqualitätssettings schlägt sich die ATI-Grafikkarte etwas besser. Zudem wird auch hier wieder recht viel CPU-Power benötigt, die mitgetesteten Athlon 64 X2 3800+ und Core 2 Duo E6400 würden die benutzten Grafikkarten meistens stark limitieren.

Als nächstes folgt das dritte Savegame [20], welches dann eine schwere Schlacht zum Thema hat:

Hierbei gehen die Frameraten gegenüber den beiden vorherigen Savegames inzwischen erheblich herunter. Auch zeigt sich hierbei die Radeon X1900 XT nunmehr inzwischen durchgehend der GeForce 7950 GT überlegen. Und letztlich würden die mitgetesteten Prozessoren Athlon 64 X2 3800+ und Core 2 Duo E6400 auch in diesem Savegame meistens erheblich limitieren.

Und abschließen wollen wir mit dem vierten Savegame [21], welches eine extreme Schlacht beinhaltet. Es ist die stressigste Szene, welche auf einer 8-Spieler-Skirmish-Map ohne Superwaffen erreicht werden konnte:

Auch in diesem Savegame liegen die Frameraten ebenfalls recht niedrig. Ansonsten weiterhin ist ähnliches wie schon im vorhergehenden dritten Savegame zu konstatieren: Die Radeon X1900 XT liegt nunmehr durchgehend vor der GeForce 7950 GT, zudem würden wiederum die mitgestesteten Athlon 64 X2 3800+ und Core 2 Duo E6400 Prozessoren die beiden benutzten Grafikkarten meistens erheblich limitieren.

CPU-Limit-Tests

Im nächsten Schritt wollen wir uns wie gewohnt noch einmal dediziert dem Vergleich zwischen den CPUs von AMD und Intel widmen. Dazu reduzieren wir die Auflösung auf 800x600 Bildpunkte und deaktivieren den anisotropen Filter sowie Anti-Aliasing, um die CPU-Limiterung so groß wie möglich zu halten (genaue Begründung hierzu [25]):

Wie schon den Anmerkungen zu den einzelnen Savegame-Messungen zu entnehmen, benötigt Command & Conquer: Tiberium Wars doch einiges an CPU-Power, um die benutzten Grafikkarten überhaupt ausnutzen zu können. Dies resultiert dann darin, daß es unter den eher stressenderen Savegames zweifellos nicht mehr mit LowCost-Prozessoren getan ist. Interessanterweise scheint Command & Conquer: Tiberium Wars jedoch keinen der Prozessorenbauer zu bevorzugen: Die in etwa mit gleichem Preis im Markt stehenden Modelle Athlon 64 X2 5400+ und Core 2 Duo E6400 kommen in diesem Spiel auf ziemlich exakt die gleiche Performance.

Mit zunehmender Verbreitung von CPUs mit mehr als einem Kern stellt sich natürlich immer die Frage nach dem Nutzen hiervon für den Spieler, daher wollen wir auch in diesem Spiel den Einfluss einer DualCore-CPU messen. Für unseren Test nutzen wir wie immer den Athlon 64 X2, da sich nur bei diesem ein Kern zusammen mit seinem Level2-Cache deaktivieren lässt. Simuliert wird das durch die Option "/numproc=1" in der "boot.ini" des Windows-Betriebssystems – nach einem Neustart ist dann nur noch ein Kern aktiv:

Command & Conquer: Tiberium Wars ist wieder einmal eines der Spiele, welche einen deutlichen Vorteil aus der Verwendung einer DualCore-CPU ziehen. Während sich dies unter eher niedrigen Anforderungen mit 18 Prozent Leistungsgewinn schon ganz anständig, aber sicherlich noch nicht wirklich überzeugend auswirkt, ergeben die im Schnitt 27 Prozent Leistungsgewinn unter eher stressenderen Bedingungen dann doch schon einen ordentlichen Vorteil für DualCore-Modelle. Mit SingleCore-Prozessoren dürfte dieses Spiel nur noch bei recht niedrigen Performanceanforderungen spielbar sein.

Es stellt sich natürlich zudem generell die Frage, wie viel Einfluss die Treiber der jeweiligen Hersteller auf die frei verfügbare CPU-Zeit haben. Um dies zu abzuschätzen, senken wir erneut die Auflösung und messen unsere Savegames sowohl mit der ATI- als auch der nVidia-Karte erneut:

Nichts wirklich spannendes ergaben diese Messungen: Beide Grafikkarten liegen bezüglich der Treiberbelastung weitestgehend auf identischem Niveau.

Test der Detailstufen

Bevor wir alle bisherigen Erkenntnisse zusammenfassen und eine Wertung abgeben, wollen wir noch den Einfluss der Detailstufe auf die Performance prüfen. Dazu nutzen wir die vom Spiel angebotenen Einstellungen "niedrig", "mittel" und "hoch" im vierten und anspruchvollsten Savegame:

[26] [26]hohe Details [21] |

|

[27] [27]mittlere Details [21] |

[28] [28]niedrige Details [21] |

In diesem muß der Athlon 64 X2 mit 2.4 GHz Takt und "/numproc=1" (und damit als SingleCore) nunmehr einen entsprechenden Test über sich ergehen lassen. Wir prüfen hierbei den Leistungsgewinn beim Absenken der Detailstufe, wobei die Grafikkarte jederzeit genügend Leistung bereitstellen sollte. Durch die Beschränkung auf nur einen Kern wird zudem der MultiCore-Support des Treibers unterdrückt. Es zählt einzig und allein, wieviel Gewinn man durch die verschiedenen Detailstufen erreichen kann:

Hierbei zeigen sich gewisse, wenn auch nicht weltbewegende Unterschiede: Zwischen den mittleren und hohen Details liegen im Schnitt 10 Prozent, was eher geringfügig ist und daher im normalen Gamer-Alltag kaum zu bemerken sein dürfte. Interessanter (aus Performancesicht) sind da schon eher die Unterschiede zwischen niedrigen und mittleren Details, welche sich auf 23 Prozent belaufen (bzw. zwischen niedrigen und hohen Details dann schon 35 Prozent). Allerdings ist der optische Unterschied auf niedrigen Details dann auch schon mehr als erheblich.

Und letztlich soll noch kurz überprüft werden, in welcher Form sich ein Performanceunterschied zwischen den Spielversion 1.03 und 1.04 ergibt:

Hier gibt es allerdings nichts zu berichten, die Performance zwischen diesen beiden Spielversionen ist identisch.

Fazit

Zuletzt wollen wir noch einmal alle wichtigen Ergebnisse in einem Diagramm zusammenfassen und dann die abschließenden Erkenntnisse auf entsprechende Empfehlung übertragen:

Hiervon ausgehend lassen sich die nachfolgend aufgelisteten Hardware-Empfehlungen für Command & Conquer: Tiberium Wars aussprechen. Anzumerken ist allerdings, dass es sich hierbei nur um grobe Empfehlungen handelt, welche ausschließlich auf Grundlage der vier von uns gemessenen Savegames entstanden. Es ist nicht auszuschließen, dass es in Command & Conquer: Tiberium Wars noch schlauchendere Szenarien gibt, dann müsste man diese Hardware-Empfehlungen eventuell auch noch entsprechend nach oben korrigieren.

Zudem wäre zu den nachfolgenden Hardware-Empfehlungen noch folgendes grundsätzlich hinzuzusagen: Wenn wir nachstehend für eine bestimmte fps-Höhe eine gewisse Hardware empfehlen, dann bedeutet dies nicht, daß diese Hardware exakt diese Frameanzahl erreicht, sondern nur, das diese Hardware die gewünschte Frameanzahl sicher erreicht und die nächstkleinere Hardware eben nicht mehr in der Lage ist, die gewünschte Frameanzahl zu erreichen. Dies ergibt jedoch auch, daß in vielen Fällen mittels der von uns empfohlenen Hardware die gewünschte Frameanzahl sogar noch deutlich übertroffen wird.

Diese Hardware-Empfehlungen gehen zudem generell davon aus, daß SLI sowie CrossFire unter Command & Conquer: Tiberium Wars mit hohen Performancegewinnen (wie unter anderen Spielen) funktionieren. Sollte dies nicht zutreffen, wäre für die nVidia-Grafikkarten oberhalb einer einzelnen GeForce 8800 Ultra Schluß (wird allerdings bei unseren Empfehlungen sowieso nicht erreicht), bei den ATI-Grafikkarten oberhalb einer einzelnen Radeon HD 2900 XT.

| in allen Szenen mindestens 15 fps | in allen Szenen mindestens 20 fps | in allen Szenen mindestens 25 fps | in allen Szenen mindestens 30 fps | |

|---|---|---|---|---|

| benötigte CPU | Athlon 64 X2 4200+ oder Core 2 Duo E6300 | Athlon 64 X2 6000+ oder Core 2 Duo E6400 | Core 2 Duo E6850 | Core 2 Duo mit ca. 3.6 GHz |

| Gfx für 1600x1200 16xAF |

Radeon X1900 GT oder GeForce 7900 GS | Radeon X1900 XT oder GeForce 7900 GS | Radeon X1900 XT oder GeForce 7900 GTX | Radeon HD 2900 XT oder GeForce 8800 GTS 320MB |

| Gfx für 1600x1200 4xAA + 16xAF |

Radeon X1900 GT oder GeForce 7900 GS | Radeon X1900 XT oder GeForce 7950 GT | Radeon X1950 XTX oder GeForce 8800 GTS 320MB | Radeon HD 2900 XT oder GeForce 8800 GTS 320MB |

| Gfx für 1600x1200 4xAA + AAA/TSA + 16xAF |

Radeon X1900 GT oder GeForce 7900 GS | Radeon X1900 XT oder GeForce 7950 GT | Radeon X1950 XTX oder GeForce 8800 GTS 320MB | Radeon HD 2900 XT oder GeForce 8800 GTS 320MB |

| Gfx für 1920x1440 16xAF |

Radeon X1900 GT oder GeForce 7900 GS | Radeon X1900 XT oder GeForce 7950 GT | Radeon X1950 XTX oder GeForce 8800 GTS 320MB | Radeon HD 2900 XT oder GeForce 8800 GTS 320MB |

| Gfx für 1920x1440 4xAA + 16xAF |

Radeon X1900 GT oder GeForce 7900 GS | Radeon X1900 XT oder GeForce 7900 GTX | Radeon HD 2900 XT oder GeForce 8800 GTS 320MB | Radeon X1900 XT CrossFire oder GeForce 8800 GTX |

| Gfx für 1920x1440 4xAA + AAA/TSA + 16xAF |

Radeon X1900 GT oder GeForce 7900 GT | Radeon X1900 XT oder GeForce 8800 GTS 320MB | Radeon HD 2900 XT oder GeForce 8800 GTS 320MB | Radeon X1900 XT CrossFire oder GeForce 8800 GTX |

Ziemlich offensichtlich ist mit dieser Endabrechnung erst einmal, daß Command & Conquer: Tiberium Wars sehr genügsam bezüglich der erforderlichen Grafikkartenpower ist. Würde man die Auflösung auf 1280x1024 absenken, dürften sogar für Mainstream-Beschleuniger sehr hohe Bildqualitätssettings möglich werden. Auch scheint das Spiel keinen der Grafikchip-Entwickler zu bevorzugen, die GeForce 7950 GT ist im Rahmen ihrer allgemeinen Leistungsfähigkeit etwas schwächer als die Radeon X1900 XT, hier gibt es keinerlei wirkliche Ausreißer zu verzeichnen.

Wie schon bei Supreme Commander [8] ist auch bei Command & Conquer: Tiberium Wars wieder einmal CPU-Leistung absoluter Trumpf – wenn auch nicht ganz so extrem ausgeprägt wie im Konkurrenztitel. Aber auch hier müssen die Prozessorenbauer die CPU-Modelle, mit welchen sich die sehr hohen Performanceanforderungen realisieren lassen, erst noch bauen. Eine besondere Präferenz für einen der Anbieter kann das Spiel im übrigen auch in diesem Fall nicht aufbieten – auch die AMD-CPUs leisten hier (soweit in hohen Taktfrequenzen verfügbar) ihre guten Dienste.

Dass Command & Conquer: Tiberium Wars dann doch etwas genügsamer als das vorerwähnte Supreme Commander ist, zeigt sich auch am Speicherverbrauch. Bei niedrigen wie mittleren Details nimmt sich das Spiel ca. 600 MB Hauptspeicher, bei maximalen Details bis zu 900 MB. Mit einem Speicherausbau von 1 GB sollte man also unter Command & Conquer: Tiberium Wars noch recht vernünftig auskommen können.